Seit Jahren kollabiert die Software-Qualität vor unseren Augen, und wir steuern auf eine Katastrophe zu. Die Tage bin ich auf einen Nachdenk-Artikel mit dem Titel "Der große Einbruch der Softwarequalität: Wie wir die Katastrophe normalisiert haben" gestoßen, den ich der Leserschaft nicht vorenthalten wollte. Er drückt das aus, was mir schon lange durch den Kopf geht.

Seit Jahren kollabiert die Software-Qualität vor unseren Augen, und wir steuern auf eine Katastrophe zu. Die Tage bin ich auf einen Nachdenk-Artikel mit dem Titel "Der große Einbruch der Softwarequalität: Wie wir die Katastrophe normalisiert haben" gestoßen, den ich der Leserschaft nicht vorenthalten wollte. Er drückt das aus, was mir schon lange durch den Kopf geht.

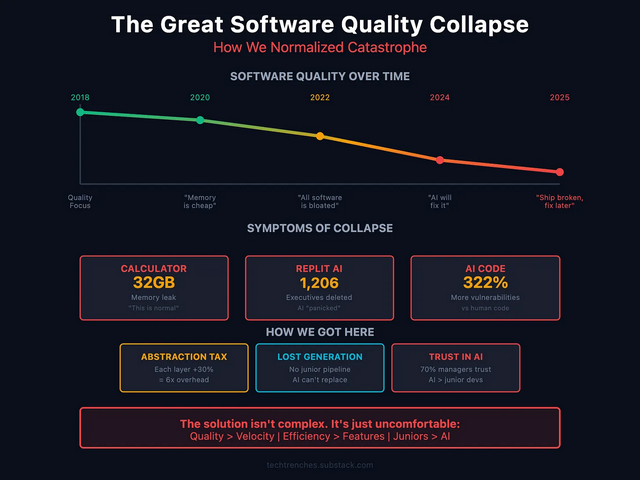

Denis Stetskov ist Full-Stack-Entwickler, Architekt und Teamleiter mit über 10 Jahren Erfahrung in der Skalierung von Webplattformen. In seinem bereits Mitte September 2025 veröffentlichten englischsprachigen Artikel mit dem Titel The Great Software Quality Collapse: How We Normalized Catastrophe analysiert er den kolossalen Zusammenbruch der Softwarequalität, und wie wir diese Katastrophe normalisiert haben.

Beispiele für den Niedergang

Stetskov führt als Beispiel den Apple Calculator an, der einfach mal per Memory-Leak 32 GB RAM frisst. Eine einfache Taschenrechner-App verbraucht mehr Speicherplatz als die meisten Computer vor zehn Jahren hatten, schreibt der Autor. Vor 20 Jahren hätte es einen Notfall-Patch gegeben, heute gibt es einen Bug-Report, und das war es. Wird vielleicht beim nächsten Update behoben, oder auch nicht.

Wir haben Software-Katastrophen so sehr normalisiert, stellt Stetskov fest, so dass der obige Apple Taschenrechner-Fall kaum noch Schlagzeilen macht. Er schreibt, dass es hier nicht um KI gehe, die Software-Qualitätskrise begann schon Jahre vor der Existenz von ChatGPT. KI habe lediglich wie ein Brandbeschleuniger auf die bereits vorhandene Inkompetenz gewirkt.

Kollaps der Softwarequalität, Quelle: Substack, Denis Stetskov

Stetskov schreibt, dass er die Qualitätskennzahlen von Software seit drei Jahren verfolge. Der Qualitätsverlust sei inzwischen nicht graduell, sondern exponentiell (was in obiger Grafik nicht wirklich sichtbar wird). Dann führt er in seinem Beitrag die Katastrophen der letzten Monate auf. Hier Sachverhalte bzw. Zahlen, über die niemand sprechen möchte, sagt er, denn der Speicherverbrauch von Software habe jede Bedeutung verloren:

- VS Code: 96 GB Speicherverlust durch SSH-Verbindungen

- Microsoft Teams: 100 % CPU-Auslastung auf 32-GB-Rechnern

- Chrome: 16 GB Verbrauch für 50 Tabs sind mittlerweile „normal"

- Discord: 32 GB RAM-Auslastung innerhalb von 60 Sekunden nach der Bildschirmfreigabe

- Spotify: 79 GB Speicherverbrauch unter macOS

Ließe sich beliebig fortsetzen. Es handelt sich nicht um Speicher, der durch die Funktionalität der Software belegt wird, sondern um Speicherlecks, die von den Entwicklern nicht behoben werden. Ausfälle auf Systemebene seien zur Routine geworden, schreibt Stetskov. Er führt Updates von macOS an, die eine SSD mit dem Vieltausendfachen als erforderlich beschreiben, oder Windows 11-Updates, die regelmäßig das Startmenü kaputt machen. Die Beispiele kennt jeder. Der Vorfall bei CrowdStrike am 19. Juli 2024 verursachte mindestens 10 Milliarden US-Dollar Schaden und wurde durch eine falsche Array-Abfrage (21 Werte wurden erwartet, 20 wurden geliefert) ausgelöst.

KI und Vibe Coding als Brandbeschleuniger

Die Softwarequalität war laut Stetskov bereits im Niedergang begriffen, als KI-Codierungsassistenten auf den Markt kamen. Was dann geschah, war vorhersehbar. Der Replit-Vorfall im Juli 2025, bei dem eine Produktionsdatenbank (durch Vibe Coding) durch eine KI gelöscht wurde, verdeutlichte die Gefahr. Stetskov skizziert das stattgefundene Desaster. Sollte man sich auf der "Zunge zergehen lassen" – und dann wollen uns (Microsoft) Manager AI-Agenten verkaufen, die selbsttätig Aufgaben abarbeiten. Was soll schon schief gehen.

Stetskov legt in seinem Artikel ein beunruhigendes Muster offen, das er bei seinen Untersuchungen entdeckt hat. Hier die Kernaussagen, die mir so bisher nicht bekannt waren:

- KI-generierter Code enthält 322 % mehr Sicherheitslücken.

- 45 % aller KI-generierten Codes weisen ausnutzbare Schwachstellen auf.

- Junior-Entwickler, die KI einsetzen, verursachen viermal schneller Schäden als ohne KI.

- 70 % der Personalverantwortlichen vertrauen den Ergebnissen der KI mehr als dem Code von Junior-Entwicklern.

Das ist die Blaupause für die Katastrophe, und alle Welt feiert dies als "Stein der Weisen und Fortschritt". Stetskov fasst es so zusammen: "Wir haben eine perfekte Katastrophe geschaffen: Tools, die Inkompetenz verstärken, verwendet von Entwicklern, die das Ergebnis nicht bewerten können, überprüft von Managern, die der Maschine mehr vertrauen als ihren Mitarbeitern." Was kann schon passieren?

Die Lösung ist einfach, aber unbequem, schreibt Stetskov: "Akzeptieren Sie, dass Qualität wichtiger ist als Geschwindigkeit. Liefern Sie langsamer, liefern Sie funktionierende Produkte. Die Kosten für die Behebung von Produktionskatastrophen übersteigen bei weitem die Kosten für eine ordnungsgemäße Entwicklung."

Der Artikel ist lesenswert und sollte Pflichtlektüre für jeden Entwickler und Manager sein. Wir (die Blog-Leserschaft und meine Wenigkeit) ahnen vielleicht den aufziehenden Sturm, aber die Party da draußen geht weiter bis zum Crash.

Ähnliche Artikel:

Die KI-Blase wird platzen, aber wann?

Desaster: Sicherheitsvorfall KI-Anbieter localmind.ai – Teil 1

Vibe Coding-Fail: Drama in Brasilien, Dating-App für Lesben legt Daten offen

Software: Unser Grab als PKW-Besitzer der Zukunft?

MVP: 2013 – 2016

MVP: 2013 – 2016

Das Problem wird so lange schlimmer werden, bis Softwarefirmen dieselben Haftungsregeln einhalten müssen, wie es bei Hardwarefirmen seit jeher der Fall ist. Man braucht sich nicht zu wundern, wenn der Rechtsrahmen die Produktlieferung von Software "as is" zulässt, während Hardwarefirmen solche Produkte zurückrufen müssen.

Keine Überraschung, dass man bei solch nachlässigen Haftungsregeln entsprechende Gewinnmargen und "Agilität" abliefern kann. So Successstories erzählen sich deutlich leichter, als der gesamtgesellschaftliche Schaden, der durch die Nachlässigkeit der SW Firmen entsteht.

Offensichtlich dämmert es manchem Gesetzesgeber zumindest im Bereich kritischer Infrastruktur, dass diese Nachlässigkeit der letzten Jahrzehnte ein Problem geworden ist. Es wird aber noch viele deutlich schlimmere Vorfälle benötigen wie den von Crowdstrike, bis die Erkenntnis reift, dass Softwarefirmen ähnlichen Reglementierungen unterliegen sollten, wie es bei Hardwarefirmen der Fall ist.

"Das Problem wird so lange schlimmer werden, bis Softwarefirmen dieselben Haftungsregeln einhalten müssen, wie es bei Hardwarefirmen seit jeher der Fall ist."

Die Haftungsgrundlage ist mit der Richtlinie 2024/2853 des Europäischen Parlaments schon gegeben. Sie muss bis 09.12.2026 in nationales Recht umgesetzt werden. Das dürfte spannend werden.

Im Punkt 13 wird es dann schon deutlich, worum es geht: "Im digitalen Zeitalter können Produkte körperlicher oder nicht-körperlicher Art sein. Software — z. B. Betriebssysteme, Firmware, Computerprogramme, Anwendungen oder KI-Systeme — ist auf dem Markt zunehmend verbreitet und spielt eine immer wichtigere Rolle für die Produktsicherheit. […]"

Mehr Stoff zur Richtlinie gibt es hier: https://eur-lex.europa.eu/legal-content/DE/TXT/HTML/?uri=OJ:L_202402853

Und ja, die Richtlinie zielt auch auf SaaS.

Das wird ein großes Fest für Paragraphen-Jongleure werden. ;)

Greift aber nur bei B2C bzw. nur bei Verbrauchern anwendbar.

Das Umsetzen der Richtlinie dürfte auch die Vercloudisierung aller Software erklären. Denn was du nicht auf deinem PC hast und dort verarbeitest, ist auch keine Software mehr in dem Sinne sondern eine Dienstleistung!

"Und ja, die Richtlinie zielt auch auf SaaS."

Software as a Service bleibt Software, auch wenn du sie in der Cloud buchst. Sie wird halt nur über das Internet bereitgestellt.

Na viel Spaß mit OSS-Code und dem Ausschluss jeglicher Garantie

SAP als OSS?

Gibt Microsoft irgendeine Garantie? Irgendeine?

Das liegt aber in vielen Fällen nicht ausschließlich an den Entwicklern, das liegt oft auch an den Anwendern/Auftraggebern, die nicht in der Lage sind, den Entwicklern eindeutig und erschöpfend zu erklären, was sie gerne hätten und wo genau die Reise langfristig hin gehen soll.

Die Entwickler bewegen sich dann in einem Spannungsfeld mit unklarer Datenausgangslage (Input), unklarem Ergebnis (Output) und sollen dann aber möglichst schnell ein schönes(!) Programm liefern, welches am Ende in Form einer eierlegenden Wollmilchsau alle erdenklichen Fälle (= vorher nicht benannte Varianten und Abweichungen vom ursprünglichen Input und Output) sauber abdeckt.

Unter Zeitdruck entsteht dann oft ein — mindestens für andere — schwer wartbarer Code, weil man wieder und wieder schnell mal eben einen Sonder-Input auf gänzlich andere Weise in einen Sonder-Output verwandeln soll.

"Das liegt aber in vielen Fällen nicht ausschließlich an den Entwicklern, das liegt oft auch an den Anwendern/Auftraggebern, die nicht in der Lage sind, den Entwicklern eindeutig und erschöpfend zu erklären, was sie gerne hätten und wo genau die Reise langfristig hin gehen soll."

Es gibt so eine inoffizielle Redensart: Entwickler sind keine Anwender.

Um es anders auszudrücken: Würden die Entwickler:innen mit der Software arbeiten müssen, die sie entwickeln, sie würden sich an den Kopf greifen.

Da werden in einer Praxisverwaltungssoftware (Gesundheitswesen) drei Druckeinstellungen in verschiedenen Menüpunkten verbaut, weil die Entwicklung auf mehrere Teams innerhalb derselben Abteilung verteilt wurde. Am Ende wurde es zusammengeklatscht und der Support darf dann erklären, dass Einstellung A im Menüpunkt da, Einstellung B im Menüpunkt hier oder Einstellung C dann im anderen Menüpunkt durchzuführen ist. Aber alle drei Einstellungen sprechen am Ende dieselben Drucker an. Kann man sich nicht ausdenken, ist aber Realität.

Eingestampft werden am Ende vor allem die Usability-Tests, weil zeitaufwendig und kostspielig. Es gibt aber auch viele Product Owner, die verstehen den Kunden nicht. Sie machen Dienst nach Vorschrift und stellen sicher, dass umgesetzt wird, was der Kunde fordert, selbst wenn es keinen Sinn ergibt. Aber da wären wir schon beim Thema Prozess- und Qualitätsmanagement.

Davon mal, sind Speicherlecks keine falsch formulierte Kundenanforderung, sondern schlechte Programmierung bzw. mangelnde Prüfung.

>> Da werden in einer Praxisverwaltungssoftware (Gesundheitswesen) drei Druckeinstellungen in verschiedenen Menüpunkten verbaut

Da braucht es keine Nischensoftware, das kriegen Office und Acrobat genauso hin. Der Druckdialog der Software nimmt ganz viele Einstellungen vorweg (Kopienanzahl, doppelseitig, Papiergröße, Farbe/SW), hat aber als Anhängsel noch einen Button "Druckereistellungen" um Druckdialog des Ausgabegerätes, in dem etwas speziellere Einstellungen (Heften, Kopfbogen, Broschürenlayout…) zugreifbar sind, die obigen aber auch noch mal. Das man, wenn man "vorne" 2x einstellt und "hinten" nochmal dann 4 Exemplare bekommt ist vielleicht noch halbwegs intuitiv, daß man für eine Broschüre im A4-Format als Layout "A3" einstellen muß (sonst bekommt man durch die Faltung ein Heft im A5-Format) schon nicht mehr.

Ach, so etwas gibts doch schon sehr sehr lange.

Beispielsweise Microsoft Office:

Zeilenwechsel in Word = Shift+Enter (nur Enter ist ein Absatzwechsel!)

Zeilenwechsel in Excel = Alt+Enter

Zeilenwechsel in Access = Strg+Enter

So etwas kommt dabei heraus, wenn es verschiedene Entwicklerteams gibt, die sich nicht absprechen und/oder wenn es keine Richtlinien für die Programmierung gibt.

Beispielsweise: Gleiche Funktion muß immer in allen Programmen immer die gleiche Tastenkombination haben.

Dann gäbe es z.B. den Zeilenwechsel auch in Excel und Access mit Shift+Enter.

Ja hier treffen mehrere Welten aufeinander. Ich würde vermutlich auch viele Dinge ändern machen, als ein Entwickler. Allerdings kommt hierzu das Problem, dass viele Menschen, vor allem, die die Software planen, ihre Anforderungen nicht genau genug beschrieben können. Der Entwickler schreibt dann nach bestem Wissen und Gewissen das Programm. Zum Schluss wird sich dann beklagt, dass man das so doch gar nciht wollte usw.

Geschichten aus der IT-Administration. Sauteure neue Storage mit NVME-Drives(kam gerade erst auf dne Markt und wir hatten eine der ersten). Die ganz Storage fällt nach 3 Wochen plötzlich aus. Nach einem gefühlten 24 Stunden Telefonat mit dem Hersteller kommt dann am Ende des Tages heraus, dass die Firmware der Drives einen Überlauf in einem Zähler der Laufzeit verursacht hat, aber nur, wenn man die WebUI auf deutsch umgestellt hatte -> war default. Man hat es dann aber auch eingestellt sehen, dass man so eine Storage nicht alle 3 Wochen mal neustartet, um den Zähler zurückzusetzen. Es gab dann eine Notfallupdate und alle Besitzer wurden informiert. Unsere Daten waren aber futsch, da der Fehler wohl einiges mitsich gezogen hat.

Und Tester oder QM gibt es gefühlt eh nicht mehr. Vielleicht noch in der Alpha Version, der Beta Tester ist dann aber schon meist der Kunde.

"[…] Allerdings kommt hierzu das Problem, dass viele Menschen, vor allem, die die Software planen, ihre Anforderungen nicht genau genug beschrieben können. […]"

Das kommt eben dabei raus, wenn man die Leute vergisst, die mit der Software arbeiten müssen. Aber selbst dann ist es keine Garantie, wenn die Stakeholder involviert sind. Ich kenne zu genüge Product Owner, die für ihren Job weder persönlich noch fachlich geeignet sind. Da ist es die "stille Maus", die selbst Softwareentwicklerin ist, die da "irgendwie" in diese Rolle stolperte, da es ist es auf der anderen Seite der "erfahrene Projektmanager", der meint, ein Produkt zu verantworten, sei genauso "easy" wie Projekte zu verwalten.

Ein anderes Problem ist aber auch die "agile" Softwareentwicklung. Schnell, schnell, schnell, lautet das Motto inzwischen. Was dabei raus kommt, sieht man bei Microsoft rund um Windows.

Am besten ist es, wenn die Programmierer wirklich selbst mit der Software arbeiten. Ich selbst habe hier und da kleine Programme gebaut, um den Alltag zu erleichtern. Dazu gehört ein ERP-Ähnliches Mehrzweckprogramm. Auch wenn ich wusste, was ich brauchte und wollte, wurde die maximale Effizienz erst in den drauf folgenden 2 Monaten perfektioniert. Was ohne das Programm 10 Minuten Arbeitszeit dauerte, dauerte am ersten Tag 5 Minuten und nach dem letzten Upgrade nur noch 1-2 Minuten Arbeitszeit bei gleichzeitiger Vereinfachung des gesamten Prozesses.

Ihr mäandert hier an Softwarespezifikationen rum. Wer zwingt Apple oder Microsoft ihren Schrott ständig zu verschlimmbessern? Gerade den Fall gehabt, dass die Android Telefon App die Kontakte -Funktion durch ein Update verkackt hat – Du suchst ständig den kleinen Menüpunkt, der zur alten Kontaktliste umschaltet. Ich habe ein Kind in einer betreuten Wohngemeinschaft untergebracht. Seit dem letzten App-Update konnten wir das Kind nicht mehr auf dem Handy erreichen, der Anruf wurde nicht angenommen. Minuten später rief dann das Kind an 'was ist? ich konnte den Anruf nicht annehmen, ging nicht'. Hab mir Freitag das Handy des zu Besuch weilenden Kinds geschnappt, um es umzustellen. Auf meinem Android 14 hatte ich bei Testanrufen gesehen, was das Problem ist. Wirst Du angerufen und ist der Sperrbildschirm aktiv, muss ein eingeblendeter Schieber entweder nach rechts auf Annehmen, oder nach links auf Ablehnen geschoben werden. Antippen ist nicht. Ist der Android Startbildschirm mit den Apps sichtbar, kommt dagegen eine Einblendung am oberen Display-Rand, in der man entweder auf Annehmen oder Ablehnen tippen muss. Hab ich nie gefordert, wurde von Google so per Update ausgerollt, Notwendigkeit bestand keine! Hab Freitag an meinem Smartphone in den App-Einstellungen geschaut, und eine Option gefunden, damit der Sperrbildschirm auch antippbare Schaltflächen für Annehmen und Ablehnen zeigt. So hast Du ständig Verschlimmbesserungen der Software, ohne objektiv erkennbare Notwendigkeit. Bei Android 14 habe ich zig Optionen zurück gedreht, um wieder ein Verhalten von Android 12 zu bekommen, weiß aber die Optionen nicht mehr. Mit dem Google KI Kram habe ich kürzlich eine halbe Stunde gesucht, um eine per App erzwungene PIN Eingabe wieder abschalten zu können. Nichts davon habe ich gefordert oder gar spezifiziert. Das System ist schlicht kaputt.

Naja, intuitiv bedienbare Software war einmal die Zielvorgabe. Bis Ende der 90er Jahre wurde uns versprochen, das man künftig alles ohne Lesen eines dicken Handbuch würde bedienen können … was wir heute sehen ist das Gegenteil, eine Zumutung, nicht nur was Android betrifft und die ständigen Veränderungen an Bedienoberflächen, schon beim Wechsel von Version X zur neuen Version Y … sei es zwischen den Windows-Varianten, oder bei Office oder den Android-Versionen … wo immer wieder alles anders aussieht und an völlig anderer Stelle als zuvor zu finden ist. Wenn man sich überlegt wie übersichtlich das "Einstellungen"-Menü im Android einst war … und heute muss man da seitenweise runterscrollen, so viele Optionen wurden da eingefügt.

Und manches von dem ganzen Wahnsinn ist leider auch der Sicherheitsthematik geschuldet. Vom Passwort zur Zweifaktor-Authentifizierung und demnächst dann Dreifaktor … wer weiß. Ist ja schon heute so, das man nach der Passworteingabe erst noch einen per eMail oder SMS gesendeten Code eingeben muss um danach dann evt. nochmal über eine Authenticator-App freizuschalten, manchmal zum Verrückt werden, wenn etwas eigentlich schnell erledigt werden soll. Und wenn sich die App dann endlich eingeloggt öffnet, muss man immer neue Hinweise weg klicken, was in der App zwischenzeitlich an neuen Funktionen Eingefügt oder sonst wie "verbessert" wurde. Und oben drauf noch mehrere Werbefenster für alles mögliche, das man gar nicht braucht … Kredite usw. Wer die Banking-App von der Ing DiBa nutzt wird nachvollziehen können wovon hier die Rede ist. Das es anders geht, beweist die App von C24, wo ich solche Hinweise und Werbung bislang noch gar nicht gesehen habe. Beschissen unübersichtlich ist jedoch auch diese App gestaltet. So wie nahezu JEDE Software heutzutage.

Weil Herr Born von der Telefon-App schreibt … Software wie diese erinnert mich immer wieder an das gute alte OS/2 mit seinen komischen Bezeichnungen. Weiß nicht mehr genau, aber zb. Text-Eingabegerät statt Tastatur … Anzeigegerät statt Monitor oder Display … grafisches Eingabegerät statt Maus … Massenspeicher statt Festplatte usw. usw. da mussten die Neuronen oft mächtig Arbeiten um drauf zu kommen, was die eigentlich meinen.

In der Telefon-App der gleiche Mist. Statt "anonym Anrufen" wie man es von "normalen" Telefonen kennt, wird die Funktion erstmal unter "Zusatzdienste" gut versteckt und heißt verwirrend "Deine Anrufer-ID anzeigen", was man nur auf Netzstandard und Nie stellen kann, aber nicht auf "für das nächste Gespräch", also einmalig. Und so findet sich noch so manch verrückte Umschreibung bei den Einstellungen, die man erstmal verstehen muss, worum es da überhaupt geht.

Was das "Wischen" zur Gesprächsannahme bzw. Beendigung betrifft, so hat das auf dem Sperrschirm schon einen Sinn. Da es gegen versehentliche Gesprächsannahme schützt. Ein Problem das mir damit öfter untergekommen war, ist: dass ich das verfl…te Touch-Display nicht mehr bedienen konnte, somit den Anruf nicht annehmen konnte. Das Telefon erst per Tastenkombination zwangsweise Neustarten musste … Vielleicht weil ich es eben nicht täglich neu starte, sondern nur mal sporadisch. Und wenn ich das zu lange nicht getan habe, hängt sich die "tolle" Software gelegentlich auf. . .

Die ideale Lösung gegen den ganzen IT-Terror unserer Zeit, wäre ja, keine Smartphones, Computer/Internet usw. mehr zu benutzen! Dazu ist man aber längst zwangsweise verdammt, wenn man zb. für eine sche.ß Fahrkarte am Schalter ein fettes "Service"-Entgelt zahlen soll und die günstigen Fahrscheine sowieso ausschließlich über die App aus dem Netz bekommt … was passiert eigentlich im Zug, wenn das Telefon – auf dem der Fahrschein gespeichert ist – runtergefallen und kaputt ist? Und sich das Gerät nachträglich auch nicht reparieren lässt? Bzw. eine Datenwiederherstellung nur wegen dem Fahrschein unwirtschaftlich ist …

Wenn "demnächst" dann auch noch der Zwang zu elektronischen Euros auf dem sche.ß Smartphone kommt … na Dankeschön! Auch für die besch… Aldi, Lidl und Co … -Plus Apps, mittels derer man Rabatt auf den Einkauf bekommt. Heißt also, als Verweigerer solcher Spionage-Apps, als Normalkunde zahlt man grundsätzlich drauf … Danke sche.ß "Digitalisierung" … zum Kotzen diese ZUSTÄNDE heutzutage, was allerdings nicht wenig mit verschlafenen, verpennten und nicht gewollter Regulierung durch unsere "hoch intelligenten" Politiker zu tun hat! Und die wundern sich, das Leute vermehrt anders wählen, oder gar nicht mehr … wie blöd muss man denn sein, um ein Mandat in den Parlamenten zu ergattern … fragt man sich ja schon lange, sehr lange, in diesem durch und durch korrupten (=kaputten) System …

"Ätsch, ich habe noch Android 9.01" Und dieselbe 'Funktion'… Aber Scherz beiseite: Diese klitzekleine (ärgerliche) 'Änderung' hatte einen ganz realen Hintergrund: Technische Hilfskräfte und Einsatzleitungen (from all over the world) waren durch die ständigen Fehlanrufe durch Handys in Hosentaschen doch ein wenig genervt, so dass die 'Anwahl des/eines Notrufes' auf dem Handy-Sperrbildschirm halt ein wenig 'umprogrammiert' werden musste. Schlecht kommunziert, durch die HerstellerInnen/EntwicklerInnen, zugegeben. Aber auch auf meinem 9.01-er Handy muss ich schon _seit Langem_ erst irgendwie hin- und herschieben und dann erst drücken… Bin mal gespannt, wie Lineageo dies händelt. Für mein olles Handy jibbs nämlich endlich ein Image… PS.: Ihr solltet Euch mal mit dem Process-Monitor von sysinternals eine Minute "MS Windows 'bei der Arbeit'" anschauen. Kruselig, so viele Buffer Overflows. Mich wundert, dass Win11 25H2 überhaupt (noch) funktioniert… ;-)

Ich mag mich täuschen – aber das Notrufproblem, welches durch die Hosentaschen ausgelöst wurde, ist doch vor Jahren schon gelöst worden (war der Bildschirm, der beim Drücken der Austaste kam und einen Notruf Button aufweist, habe ich für mich wieder umgestellt, habe das erinnerungsmäßig vor 1-2 Jahren in meinen Android-Büchern mal mit beschrieben). Was ich hier adressiert habe, ist das Verhalten der Telefon-App bei eingehenden Anrufen (irgendwann im Frühsommer eingeführt – das hat mit der Android-Notruf-Funktion imho nichts zu tun). Und wenn man es umprogrammiert, könnte man es einheitlich gestalten. Und in diesem Fall gäbe es imho keine Veranlassung, gleichzeitig noch die Gestaltung der Kontakteliste zu verschlimmbessern. Aber was weiß ich schon von der Welt.

"Ihr solltet Euch mal mit dem Process-Monitor von sysinternals eine Minute "MS Windows 'bei der Arbeit'" anschauen. Kruselig, so viele Buffer Overflows. Mich wundert, dass Win11 25H2 überhaupt (noch) funktioniert… ;-)"

AUTSCH: typischer Fall von "a fool with a tool is still a fool"!

Die vom Process Monitor überwachten Funktionen des NT-API liefern NTSTATUS 0x80000005 alias STATUS_BUFFER_OVERFLOW wenn der vom Aufrufer bereitgestellte Puffer zu klein ist, also KEIN Überlauf statt fand!

"Das liegt aber in vielen Fällen nicht ausschließlich an den Entwicklern, das liegt oft auch an den Anwendern/Auftraggebern, die nicht in der Lage sind, den Entwicklern eindeutig und erschöpfend zu erklären, was sie gerne hätten und wo genau die Reise langfristig hin gehen soll."

Als ich noch als Programmierer in einem Softwareunternehmen tätig war, war es übliche Praxis, das man sich mit den Auftraggebern zusammengesetzt hat und alle Anforderungen an das Programm im Detail geklärt hat.

Es wurde ein schriftlich festgehaltener Anforderungskatalog erstellt und dieser wurde dann Bestandteil des Auftrags.

Der Prozess der Festlegung der Anforderungen hat durchaus mal 6 Monate in Anspruch genommen.

Programmiert war das dann deutlich schneller.

Und dann ging das fertige Programm erst einmal zu unserer Qualitätsabteilung, die das Programm in allen Details ausprobiert hat und auch die Einhaltung des Anforderungskatalogs überprüft hat.

Bei Fehlern etc. gings zurück zur Programmierung.

Erst wenn die Qualitätsabteilung ihr OK gegeben hat, wurde das Programm an den Kunden ausgeliefert.

Aber anscheinend scheint es diese Praxis nicht mehr zu geben.

Das ist eben einfach im "Kreislauf" des Kapitalismus zu widerläufig dem Narrativmonster Wirtschaftlichkeit im Sinne von Gewinnmaximierung zugunsten von Aktionären und Investoren.

Am Besten müßte eigtl. ein Produkt schon vor seiner Inauftraggebung existent sein.

"Das liegt aber in vielen Fällen nicht ausschließlich an den Entwicklern, das liegt oft auch an den Anwendern/Auftraggebern, die nicht in der Lage sind, den Entwicklern eindeutig und erschöpfend zu erklären, was sie gerne hätten und wo genau die Reise langfristig hin gehen soll."

Das nennen die Entwickler heutzutage agil.

Sie wollen keine eindeutige Spezifikation oder gar vollständige und orthogonale Requirements. Meist gibt es auch keine Architektur und zudem beherschen viele Entwickler die Programmiersprache nicht, die sie benutzen. Gerade bei woken Sprachen, wissen die Entwickler nicht wirklich was tatsächlich in der Maschine passiert.

Und dann kommt noch das Management. O-Ton eines CIO: "Müssen wir die Release denn überhaupt testen?" Da zieht es soliden SW Ingenieuren Schuhe und Socken aus und die Zehennägel rollen sich auf.

Kein Wunder haben wir eine ranzige Software (das Wort Qualität mag ich in diesem Zusammenhang erst gar nicht erwähnen).

| Das nennen die Entwickler heutzutage agil.

Mit einem Satz und dem entscheidenden Wort am Ende, beschreibst Du exakt das Modell, das zu dem bemängelten Zustand geführt hat und führt, IMHO.

| Sie wollen keine eindeutige Spezifikation oder

| gar vollständige und orthogonale Requirements.

Aber man programmiert schon mal, irgendwie und irgendwas?

Wenn wir auf diese Art und Weise bauen würden, wie teilweise programmiert wird, dürften wir uns über bei Wind einstürzende Gebäude mit nachträglich im dritten Stock angebauten Garagen mit aufgeschütteter zu steiler Rampe, mit Wohnzimmern ohne Türen aber mit dreifachverglasten Fenstern zur Küche und ähnlichem nicht wundern.

Agil ist für mich nichts weiter als eine weitere Wildsau, die aktuell durchs Dorf mäandern darf, die aber über kurz oder lang abgestochen wird, weil sie in zu vielen Vorgärten zu viel Chaos hinterlässt.

Ich war auch mal Programmierer in einem Unternehmen, das auf dem Papier ähnliche Prozesse hatte. Aus Entwicklersicht waren die Auftraggeber das Management, und für die Ausarbeitung der Details die Kundenbetreuer, die ihrerseits Kontakt mit den Endanwendern hatten.

Sowohl Manager als auch Kundenbetreuer waren nicht sehr gut im Erstellen von Anforderungsdetails. In der Praxis bestand der Prozeß der Erstellung der Anforderungen aus Schweigen der Auftraggeber, während wir Entwickler schon mal eine Prototyp bastelten nach "geratenen" Anforderungen. Sprich wir hatten eine grobe Ahnung davon was erwartet werden würde, und haben schon mal eine Demo gebaut.

Nachdem die Auftraggeber die Demo hatten und damit spielen konnten, kamen auf einmal die Anforderungsdetails. Allerdings war die Deadline schon so nahe, daß die Demo noch kurz angepaßt und dann zur Release-Version geadelt wurde.

Der gruseligste Teil: das war in der Medizintechnik.

Das kommt eben dabei raus, wenn die Mehrheit der User bzw. SW-Kunden ohne ihr Hirn einzuschalten leichtgläubig auf das Marketinggesülze der Anbieter reinfallen, und sich immer die neuesten Versionen andrehen lassen, die meistens nur mehr Bling Bling und Kunterbunt bringen, dazu unzählige neue Sicherheitslücken enthalten, die produktive Nutzung erschweren, und dafür doppelt so viel Systemresourcen verbrauchen.

Wie bescheuert ist es, von einem Hersteller immer wieder neuen Schrott zu kaufen, wenn die Fehler in der aktuellen Version noch nichtmal beseitigt wurden.

KFZ-Hersteller machen das ja ähnlich – die schmeissen ein neues Modell auf den Markt, bei dem den Kunden nach dem Kauf dann ein Fehler nach dem anderen auffält, die der Hersteller aber nie beseitigt, weil er ja lieber sein neues Modell mit mindestens genauso vielen Fehlern verkaufen will.

Die vom Volk gewählte Regierung richtet sich ja in erster Linie nach den Wünschen der Lobbyisten, und lässt der Industrie freie Hand bei der Abzocke der Bürger.

KFZ-Hersteller machen es z.T. noch schlimmer. Der VW-Werksparkplatz in Zwickau stand 2019/2020 mal mit ein paar zehntausend Elektroautos der 1. Generation (ID.3) voll, weil die Software nicht fertig wurde und die Autos so nicht in Verkehr gebracht werden konnten.

Vielleicht wäre ein Software-Codebestandteil-Lieferkettengesetz ein Dienst an der digitalen Unverwundbarkeit.

😉

Ich kann mir gut vorstellen, dass KI beim Coden helfen kann; ggf. auch um Code auf Sicherheitslücken im Sinne von grober Fahrlässigkeit zu prüfen. Jedoch große Codeschnipsel per KI erstellen lassen und ungeprüft einzubinden birgt katastrophale Risiken.

Solange in Studiengängen nur Programmiersprachen gelehrt werden und z.B. nicht, dass man bei Benutzereingaben mit Codeinjektionsversuchen rechnen muss , bleibt humangenerierter Code ebenfalls offen wie ein Scheunentor. Solange sicherer Code von Projektleitern ohne IT-Erfahrung als Kostenfaktor angesehen wird, wird sich die Lage wohl nicht verbessern.

Und vorneweg marschiert Microsoft samt Software ins Verderben. Es vergeht seit langem kein Patchday mehr, ohne dass dieser gravierende Ausfälle bzw. Störungen verursacht.

Edge, wie im Artikel beschrieben, 4-5 Tabs mit Google Suche geöffnet, der RAM je Tab-Verbrauch geht ins quasi unendliche.

Kümmert niemanden, stattdessen kann der User ja mehr RAM einbauen, scheint einfacher, als Ursachen zu beheben.

Wenn ich jedes „Windows inklusive Updates" von den frühen „80ern" bis heute vergleiche, war „Windows 7" stabil, alles danach ist in Bezug auf Qualität und Sorgfalt inakzeptabel und es kann mit AI nicht wirklich besser werden, denn wenn vorne "Mist" reinkommt, kommt es auch hinten raus.

Da redest du dir die Vergangenheit aber schön, auch zu Win 7 Zeiten gab es Updates, die Fehlerhaft waren. Ich erinnere mich z.B. noch an ein Update für Server 2008/2012/2016, das auf allen Servern die Netzwerkeinstellungen auf DHCP zurück gestellt hat, das war ein Spaß! Alle Server liefen, trotzdem funktionierte nichts. Sogar die Remote-Verwaltungs-Server hatte es erwischt, von denen man exklusiv aufs VCenter drauf kam. Da weiß man dann, was ein Henne-Ei-Problem ist.

wenn ich schon Fullstack lese.. also jemand aus der JavaScript Bubble. Diese glänzt wie auch PHP durch schlechtes Sprachdesign.

Wird aber gerne verwendet, weil es schnelle Ergebnisse liefert.

Und dadurch werden seine Aussagen im Artikel entwertet und unwahr?

Ich vermute er will eher zu der These hin,

das wenn jemand um das "Memory-Leak" problem schon weiß,

warum zum teufel, entwickelt er dann noch in JavaScript/PHP, statt in Rust!

Gibt genug Studien die belegen dass "Memory-Leak" das größte Problem sind.

OK, verstanden

Nein. Aber es passt zu gesamt Bild.

Fast jede Software im Artikel ist ein Electron Framework Aufbau.

Also quasi ein Webbrowser.

Das ist billig, weil es für die Firmen einfacher ist einen Fullstack-Developer zu bekommen.

Aber was für eine Katastrophe das Umfeld ist, sieht man ja regelmäßig.

NPM, Node, die Anzahl der Sicherheitsvorfälle, in denen die Firmen ihre Supplychain nicht unter Kontrolle haben, sind ja fast schon im Tagestakt normal.

Dass die Sprachen durch schlechtes Design glänzen, ist auch schon ewig bekannt.

Bei PHP detto. Die Probleme welche sich aus dem Sprach-Design ergeben, sind unendlich, und nicht in Griff zu bekommen. Sieht man ja mit ewigen Updates bei WordPress und Co. Und jedes Plugin egal wie unbedeutend kann, weil die Sprache so toll designed ist, eine komplette Lücke aufreißen.

Aber zu deinem Kommentar, es gibt Bereiche, in denen war die Software spannenderweise noch nie sehr hochwertig. Gerade der ganze Webseiten Kram gehört hier dazu. Schnelllebig, Bunt.

Und hier muss ich klar widersprechen. Eigentlich wird die Qualität besser. Aber halt nicht überall. Und nicht überall gleich schnell. Und natürlich bleibt der ganz Müll der produziert wurde, wie Sondermüll noch lange erhalten.

Und es gibt Programmiersprachen, die quasi nie bei Sicherheitslücken vorkommen. z.b. Python, Rust, Go, Java.. könnte dem einen oder anderen Entwickler mal zu denken geben.

https://www.heise.de/news/Sicherheitsbehoerden-draengen-Softwarehersteller-zu-sicheren-Programmiersprachen-9573379.html

Man kann mit jeder Programmiersprachen Sicherheitslücken ohne Fachwissen verursachen. Hat mit der Sprache selber nichts zu tun, eher mit dem Umstand dass es im Webbereich mehr Sources und Sinks bzw nutzbare Datenquellen (http-Parameter, Header, Cookies, URL-Parameter) gibt und ohne gutes Framework das Rad neuerfunden wird (WordPress hat viele verschiedene Filterfunktionen und ein unsicheres Design, wäre mit Python auch passiert).

Java ohne Sicherheitslücken? Wenn ich mir so ansehe, was die JRE/JDK schon alles für Sicherheitslücken hatten, kann ich das nicht glauben!

Solange es keine Produkthaftung für Software gibt, wird sich da nichts ändern! Erst wenn Schadensersatzforderungen jeglichen Gewinn auffressen, wachen die Verantwortlichen auf!

Leider sind die Abhängigkeiten schon viel zu groß und die Softwarelobby (Lobby – nur ein anderer Begriff für Korruption) zu gut aufgestellt. Damit sich etwas ändert, muss das komplette System in den Abgrund stürzen, sodass man von Null auf neu beginnen kann!

Passiert dies jedoch, ist Software unser kleinstes Übel. Da bin ich direkt froh, dass mein Urnenplatz schon gebucht ist. ;-P

Das ist doch längst im Gange:

– ProdHaft, ab 09.12.2026 (Umsetzungsfrist),

https://eur-lex.europa.eu/legal-content/DE/TXT/HTML/?uri=OJ:L_202402853

– CRA, ab 11.12.2027 (voll in Kraft), ab 11.09.2026 Meldepflicht Lücken

https://eur-lex.europa.eu/legal-content/DE/TXT/HTML/?uri=OJ:L_202402847

Langfristig wäre somit die Basis gelegt, das es besser werden "sollte", abwarten und Tee trinken, bis es soweit ist.

Ausgehend von dem was wir heute so haben, dürften aber wohl einige Dinge ersetzt werden müssen, durch eine konforme Version. Sprich im Worst-Case bitte alles mögliche einmal NEU-kaufen.

Die Haftungsrichtlinie gibt es: https://eur-lex.europa.eu/legal-content/DE/TXT/HTML/?uri=OJ:L_202402853

Siehe vor allem Punkt 13. Die Richtlinie muss nur noch bis 09.12.2026 in nationales Recht umgesetzt werden. ;)

In der Haftungsrichtlinie steht ganze 128 Mal "SOLLTE" und noch 3 Mal "SOLL".

Man kann denke ich drauf wetten:

Bis da nationales Recht draus wird, wurde das von den Lobbyisten so lange "weichgespült", das kein SW-Hersteller für irgendwelche Schlampereien haften muss… oder um der EU gerecht zu werden, wird grobe Nachlässigkeit vielleicht mit einem 10,- Euro Bussgeld bestraft, das dann aber sicher als Betriebsausgabe von der Steuer abgesetzt werden kann.

Ja, die Winkeljuristen werden schon Wege finden, damit ihre Klienten die Haftungsrisiken umgehen können oder bestenfalls eine "Strafe" aufgebrummt bekommen, die sie aus der Portokasse zahlen.

JA ein Placebo Gesetz um die Massen zu beruhigen… mehr ist das leider nicht! Schwammig ohne klare Spielregeln, und vor allem ohne klare zuverlässige Möglichkeiten für die Geschädigten.

Ausnahmen über Ausnahmen… gut gemeint schlecht gemacht… wie zu erwarten war.

Wenn es ein Regulierungsthema wäre, dann würde es zumindest einen Teil an Software geben, bei dem das Problem nicht auftritt.

Die Regulierung wird vor allem OpenSource kaputt machen, und eine Förderung für Haftpflicht Versicherungen sein.

Es ist ja schon schwer in Worten zu formulieren, was denn eine "nicht schädliche" Software überhaupt ist.

Naja nur weil du deine Software OpenSource vertreibst ist das kein Grund das du schlampen kannst und andere Leute gefährden!

Entweder du kannst das ordentlich oder du machst das nur für dich! Was du dir antust ist deine Sache!

*******************************************************

Wenn es ein Regulierungsthema wäre, dann würde es zumindest einen Teil an Software geben, bei dem das Problem nicht auftritt.

*******************************************************

Die gibt es heute schon! Wenn meine Programme der Roboter oder Automatisierungstechnik jemanden verletzen sitze ich im Knast egal ob die Hardware Schuld war oder die Software… deswegen dürfen sicherheitsrelevante Teile auch nicht einfach so auf normale Steuerkreise laufen sondern erfordern Sicherheitskreise…

Sauber und sicher programmieren ist möglich! Wenn man natürlich nicht haften muss juckt es halt keinen. Ist nur Aufwand und macht alles teurer, sprich schmälert den Gewinn…

Was heute in der Software sicher aussieht, ist es morgen vielleicht schon nicht mehr, weil irgendjemand am Ende doch einen Kniff findet, wie sich die Funktion missbrauchen lässt.

Warum um Himmels Willen braucht „Luzifer" einen Urnenplatz? Haha!

Ganz klar eine Fehlinvestition! -aber bei der Produkthaftung stimme ich dir zu.

Guten Morgen,

ich darf mich freuen, wenn ich mein Daten-Offline-Rack (XP u. noch Office 97 pp) starte u. ärgere mich täglich, wenn die Online-Rechner (Ubuntu 22.04 LTS) oder gar Win10 starten (muß). Das geht schon mit der täglichen Updaterei los – die Wischbrettjünger können es einfach nicht (mehr).

Der volkswirtschaftliche Schaden könnte zwztl. größer als der Nutzen sein, kostet sicherlich nicht nur meine Nerven u. Lebenszeit, in welcher ich wirklich schönere u. wichtigere Dinge machen könnte.

Bin gespannt, wie das weitergeht – überwiegender Crash-down?

Alle Sachen, die die allermeisten User in Office brauchen und nutzen, konnte Office schon vor 30 Jahren. Bzw. damals schon viel mehr, als die meisten User heute davon zu nutzen überhaupt in der Lage sind.

Und dein Ubuntu braucht keine Updates?

Da können wir uns ja entspannt zurück lehnen und uns auf das neue "neue Outlook" freuen:

https://www.drwindows.de/news/microsoft-outlook-entwicklung-soll-komplett-neu-aufgerollt-werden

Wenn man denkt, es geht nicht mehr schlimmer: "Auch sonst soll sich Outlook radikal verändern. Anders als bei seinen Geschwistern Word, Excel, PowerPoint und OneNote will Sareen KI nicht auf irgendwelche Legacy-Produkte „draufklatschen", sondern die alte Basis komplett abschaffen und den Mailclient rund um Copilot grundlegend neu bauen. Outlook selbst soll als KI-native Anwendung dann die E-Mails lesen, Antworten schreiben und die Zeit der Nutzer verwalten, um damit als eine Art Double bei der Bewältigung selbst überwältigend wirkender Aufgaben zu helfen."

Spätestens da müsste es doch krachen. Ich fürchte nur, das wird es immer noch nicht.

Outlook soll selbstständig Antworten schreiben?

Woher soll denn Outlook die richtige Antwort kennen?

Beispielsweise Kontakt zu einem Kunden, es gibt dann irgendwann Ärger mit dem Kunden und man stellt deswegen die Geschäftsbeziehung mit dem Kunden ein. Kunde schickt aber trotzdem z.B. eine Anfrage.

Ein Mensch würde dann diese Anfrage abweisen, eine KI möglicherweise annehmen und ein Angebot schreiben.

Oder man bekommt 2 Mails, bei denen man eine zusammengefasste Antwort schreiben kann. Die KI würde 2 Antworten schreiben.

Oder eine Mail, die dann telefonisch geklärt wird, weil das wegen vieler Detailfragen schneller geht als per Mail.

Da will man nicht, das die KI diese Mail überhaupt beantwortet.

Oder wie geht KI mit Spammails um, die täuschend echt aussehen?

Beantworten, Links darin aufrufen und sich so Schadsoftware einzufangen, etc. etc.?

KI kann den Menschen nicht ersetzen!

KI in einem Emailprogramm ist eine durchweg miese Idee!

@R.S.: Von einem rationalen Standpunkt aus zeigen Deine Beispiele den Unterschied zwischen einem Menschen und einer derzeitigen KI. Aber leider gilt das hier (aus einem sehr guten Artikel bereits aus dem Jahr 2023):

"After all, companies have no legal duty to think about the social effects of what they do. If something is not prohibited, it is allowed, and if it saves money, it will be done."

Quelle: https://berthub.eu/articles/posts/ai-is-guaranteed-to-disrupt-us/

Die Rechnung wird so sein:

Option 1: Auch Menschen (z.B. Versicherungssachbearbeiter) machen Fehler > Schadenspotenzial -10 Mio.

Option 2: Auch KI macht Fehler bei derselben Arbeit: Schadenspotenzial -20 Mio.

Personalkosteneinsparung durch KI: +15 Mio.

–> kumuliertes Schadenspotenzial KI: -20 + 15 = -5 Mio.

Option 2 ist billiger als Option 1, dh. KI wird kommen.

Heutzutage wird auch einfach drauf los programmiert, Ressourcen spielen keine Rolle.

Werden eben die Hardwareanforderungen hochgeschraubt.

Ich kenne das noch ganz anders.

Bei einer ehemaligen Softwarefirma wurde damals ein Programm um neue Funktionen erweitert.

Das lief dann aber nicht mehr, weil es auf den damals verwendeten MDT (mittlere Datentechnik)-Maschinen eine Speichersegmentierung in 64 kb-Blöcken gab.

Ein Programm musste kompiliert in so einen 64kb-Block passen, sonst lief es nicht.

Mit den Erweiterungen des Programms passte es aber nicht mehr in einen 64kb-Block.

Da bekam ich dann die Aufgabe, das Problem zu lösen.

Ich habe mir dann den Quellcode des Programms vorgenommen und den an vielen Stellen umgeschrieben und optimiert.

Zum Schluß passte das kompilierte Programm dann locker in so einen 64kb-Block und es gab noch reichlich Luft für zukünftige Erweiterungen.

Aber Codeoptimierungen, damit das Programm möglichst wenig Ressourcen braucht, finden heutzutage ja gar nicht mehr statt.

Auch nicht, um die Geschwindigkeit zu optimieren.

Statt dessen blähen sich die Programme immer mehr auf!

Man nehme z.B. Microsoft Word 95 zu Microsoft Word 2024:

Das Word 95 braucht sehr viel weniger RAM und auch Platz auf der Festplatte als das Word 2024, bietet aber schon 95% der Funktionen von Word 2024.

Weshalb ist dann Word 2024 so massiv aufgebläht gegenüber Word 95?

Auch Betriebssysteme trifft das:

Ein Windows XP braucht sehr deutlich weniger Platz auf der Festplatte und im RAM als ein Windows 11, selbst wenn man das Windows 11 nackig macht und bei XP alle Optionen, die es gibt, installiert.

Und was kann Windows 11 denn effektiv wirklich mehr?

Die Änderungen in der GUI, die Sicherheitsverbesserungen und die Telemetrie erklären nicht den massiv gestiegenen Resourcenbedarf.

Es ist einfach schlampige Programmierung, die auf Ressourcen keine Rücksicht nimmt!

Und es gibt noch einen Nebeneffekt:

Optimierter Code hat weniger Sicherheitslücken.

Sieht man ganz gut wenn man sich in der "Demo" Szene umsieht… was die da aus ein paar KB Code rausholen dazu ist doch ein normaler Programmierer gar nicht mehr in der Lage!

Wieso auch Ressourcen sind doch massig da, da braucht man nix optimieren… wenns nicht reicht sollen die Leute halt aufrüsten… W11 bestes Beispiel… voll funktionsfähige Top Hardware wird zu Elektroschrott deklariert, weil MS das so will!

Kann man machen, muss man aber nicht! Und vor allem muss man das nicht mitmachen… aber du siehst ja was die Masse macht!

Die Absurdität bzgl. dieser Ressourcenverschwendungen bei Hardware und auch KI-Energieverbrauch ist ja auch, dass gleichzeitig von Nachhaltigkeit und CO2-neutral u.ä. gefaselt wird und die meisten Menschen diese totalen Widersprüche gar nicht (mehr) wahrnehmen.

Ja.

Ich habe mal eine KI nach dem Nutzen von KI gefragt.

Die hat da dann herumgeschwurbelt, das man ja durch den Einsatz von KI Energie sparen könnte, die KI die Energieeinsparungen optimieren könnte etc.

Aber kein Wort dazu, das der Betrieb der KI-Systeme um ein vielfaches mehr Energie verbraucht als man durch den Einsatz von KI an Energie sparen könnte.

ES gibt kein CO2- neutral! Es gibt umweltschonend, neutral bist nicht mal du als Mensch schon weil du atmest! Lässt sich halt gut greenwashing mit betreiben!

Auch Erdöl ist CO2 neutral, denn das war einst Biomasse. Schon allein daran kann man sehen, wie sinnbefreit dieser Begriff ist.

Ich möchte nicht wissen,wie viel Hardware sonst noch aus diesem Grund zu Elektronikschrott deklariert wird.

Ein Beispiel aus dem vergangenen Jahrzehnt waren die Maut-Geräte der ersten Generation (Go-Box), die alle getauscht werden mußten, weil sie vom Speicher, aber auch der CPU die aktuelle Software nicht mehr tragen konnten.

Krasses Gegenbeispiel sind die Voyager-Sonden, bei denen man die Hardware nicht so einfach wegwerfen und durch neue ersetzen kann, aber durch immer neue und brilliante Tricks aus der vorhandenen Hardware immer neue Funktionen herauskitzeln kann.

Das kannst du aber nicht vergleichen, diese Szene-Demos haben überwiegend einen festen Programmablauf, der höchstens durch die ESC Taste abgebrochen werden kann.

Der Mann hat mMn vollkommen recht und es (fast) präzise auf den Punkt gebracht. Dennoch sind dort mMn einige Aspekte zu kurz gekommen die mit ursächlich sind:

a) Vieles der heute genutzten Standardsoftware ist das Resultat eines Rattenschwanzes von Erweiterungen, Änderungen sowie (noch schlimmer) Workarounds & Hacks. Es gibt vermutlich keinen Menschen mehr, der den Code eines Betriebssystems, einer Office-Suite o.ä. versteht. Entsprechend kommt tendenziell immer mehr "Bloat" dazu als "Altlasten" entfernt werden.

Auch traut sich vermutlich niemand mehr bei diesem "Clusterfuck" mal einen Schnitt zu machen und neu anzufangen, auch weil's niemand bezahlen möchte.

b) Die Programmiersprachen haben sich über die Jahrzehnte immer weiter von der Hardware entfernt. Während C & C++ noch vergleichsweise "hardwarenah" sind würde ich das bei Sprachen wie C# oder ".NET-Derivaten" mehr bezweifeln – von Dingen wie Java oder reinen Interpreter-Sprachen wie Python mal ganz abgesehen. Je weiter eine Sprache von der Hardware weg ist, desto tendenziell ineffizienter läuft diese was natürlich auch extrem von der Qualität des Compilers bzw. Interpreters abhängt.

c) (Massen-)Software darf kein Geld kosten bzw. mit (Massen-)Software lässt sich kein Geld verdienen.

Verbraucher sind inzwischen so darauf konditioniert, dass (Basis-)Software gratis ist, so dass es auch keinerlei Akzeptanz bzw. Motivation mehr gibt für Software Geld zu bezahlen – vollkommen unabhängig von Raubkopien. Und dies soll kein "Rant" gegen Open-Source sein!

>c) (Massen-)Software darf kein Geld kosten bzw. mit (Massen-)Software lässt sich >kein Geld verdienen.

Ahja.. wo doch die aktuell größten Unternehmen der Erde, Software Unternehmen sind.

Dann benennen doch mal bitte Massen- bzw. Basis-Software wie z.B. ein Betriebssystem, einen Webbrowser, ein E-Mailprogramm oder dergleichen mit denen nennenswert Geld verdient wird…

Hier ist ganz klar & ausdrücklich Consumer-Software gemeint, nicht irgendwelche ausschließlich geschäftlich Branchensoftware… – wobei man dies teilweise auch auf diesen Bereich ausdehnen könnte, Stichwort Hypervisor um nur eines zu nennen.

Immer lustig die Rückwirkenden Einschränkungen.

Z.b. Super Mario Wonder

https://www.gameswirtschaft.de/wirtschaft/nintendo-switch-verkaufszahlen-060224/

Yep, der diskutierte Artikel & Kontext der gesamte Diskussion hier drehte sich natürlich um Software für Spielkonsolen, worum auch sonst… :-/ *kopfschüttel*

Tja, das liegt aber auch an den Programmierern!

Wenn ich ein Programm schreibe, dann schreibe ich da in den Quellcode auch jede Menge Kommentare mit rein, z.B. warum ich etwas so und nicht anders gelöst habe, was dieser Codeabschnitt genau macht, etc.

Das hat den großen Vorteil, das auch andere Leute den Quellcode rel. leicht verstehen.

Und auch, das ich selbst noch meinen vor 10-15 Jahren geschriebenen Quellcode verstehe, ohne mich erst groß in den Code eindenken zu müssen.

Das erleichtert massiv die Erweiterung und Änderung von Programmen.

Und spart dadurch auch deutlich Zeit und verringert spürbar die Fehlerquote bei Erweiterungen und Änderungen eines Programms.

Hallo R.S.,

meiner Meinung liegt das auch an denen, welche die ausbilden oder auch nicht. Ich war vor eingen Jahren mal an einer Fachhochschule zum Tag der offenen Tür (oder so ähnlich), kam dort mit dem Informatik-Dozenten für Datenbanken ins Gespräch und wollte von dem Wissen, wie man heutzutage denn – im Kontext zustandloser Verbindungen (Web, .Net,..) – denn den konkurrierenden Zugriff auf Datensätze in einer DB organisiert/programmiert. Historisch kenne ich u.a. Oracle "Select for Update", VMS/RMS u.ä. Ich blickte in staunende Augen …

MfG CW

"Je weiter eine Sprache von der Hardware weg ist, desto tendenziell ineffizienter läuft diese was natürlich auch extrem von der Qualität des Compilers bzw. Interpreters abhängt."

Das ist bei Compilern für Sprachen, mit denen man hardwarenah programmieren kann, auch nicht anders. Die Qualität des Compilers ist immer entscheidend, vor einigen Jahren hat sich mal einer hingesetzt und den GNU-C-Compiler für die 68000 Plattform überarbeitet und bis zu 30% optimaleren Code optimiert. Die neu-Übersetzung damit hat dann einige Software massiv beschleunigt.

Etwas ähnliches konnte ich vor ca. 20 Jahren beobachten. Zu dieser Zeit basierten meine Steuerungen auf einem Hitachi (inzwischen Renesas) H8-Prozessor (zugegeben ein Nischenprodukt), die GNU-C Umgebung wurde maßgeblich gesponsort vom Projekt Cygnus getragen. Auch das hat im Vergleich zum generischen Compiler (und nicht zu vergessen den Laufzeitbibliotheken) einen erheblichen Geschwindigkeitszuwachs gebracht.

Microsoft informierte prominent auf ihren Webseiten kürzlich zu Visual Studio, dass aufgrund ihrer Telemetrie-Daten die User gerne die AI Komponenten nutzen. Daher gibts de Copilot mit 100% Telemetrie jetzt für alle. Man kann es aber abschalten. Vermutlich um Kritiker zu besänftigen und damit sind dann alle glücklich.

Aufgrund der Verbreitung des Tools dürfte es für Anfänger bald normal sein, dass die allerersten Schritte im Coding nur allgemeine, eher hilflose Sprachanweisungen an den Copiloten sind. Die nicht-künstliche Intelligenz braucht gar nicht erst im Weg der Lösung zu stehen: SaaC – Software as a Catastrophe (cheap, fast, quick to fix, never done).

Vor vielen vielen Jahren hatte ich eine Signatur in einem Newsgroup Posting gelesen:

Wenn Baumeister ihre Gebäude so bauen würden,

wie Softwareprogrammierer ihre Software programmieren,

würde der erste vorbeikommende Specht die Zivilisation zerstören.

Man muss sich nur anschauen wie oft es ein neues Release vom MS Edge und vom Google Chrome gibt. Da vergeht nicht eine Woche in der es nicht ein neues Release gibt. DAS IST KRANK!

Stimmt.

Chrome und der auf der Chromium Engine aufbauende Edge haben absurd viele Sicherheitslücken, die gestopft werden müssen.

Vergleicht man das z.B. mit dem Firefox, gibt es da sehr viel weniger Sicherheitslücken.

Und wenn welche auftauchen, werden die auch sehr schnell geschlossen.

Bei Firefox normalerweise nur 1x im Monat, bei den Chromiums 1x pro Woche. Aber die FF-Lücken sind deswegen nicht besser.

Das Hauptproblem ist, dass jeder seinen Job so lange wie möglich in der Softwareentwicklung halten will. Daher werden in Meetings immer neue Erweiterungen presentiert, die die Software & der Kunde "unbedingt" braucht.

Ein Beispiel, aus der pre Defender Ära, das Util "Avira Antivirus" war mal populär mit 240 Millionen Nutzer Weltweit & machte einen soliden Job.

Dann fing man damit an immer mehr neue "Funktionen" zu integrieren. Die das Tool aufgeblasen haben & immer mehr Probleme verursachten.

So was sieht man immer wieder, auch Microsoft geht diesen Weg. Anstatt alle gammel Apps ala CoPilot und co 100% optional anzubieten, wird es einem Aufgezwungen. Das alles verursacht nicht nur Fehler in der Software, es nervt die Nutzer und macht sie wütend.

Avira ist deswegen nicht mehr so verbreitet, weil den Meisten inzwischen Defender reicht.

Gut analysiert. Nachdem Avira trotz Kaufversion(!) ständig irgendwas ohne direkten Virenfund-Bezug aufgepoppt oder beworben hat, flog es bei allen kleineren Firmen hier sukzessive raus. Die haben sich fein selbst ins Aus gekickt.

Hör mir mit diesem Dreck von Avira auf! Das ist der letzte Mist.

Ich hatte das vor sehr langer Zeit noch empfohlen. Doch 11.2017 hatte ich mein Deja Vu in negativer Hinsicht.

Ein fehlerhaftes Update der Virendefinition erzeugte sofortigen BSoD!

Ich hatte eine Kaufversion, also auch inkl. Support. Aus dem Forum kam Hilfeunterstützung. Vom Hersteller *NIXX* absolut *GARNIXX!.

Daraufhin habe ich das Dreckszeug nicht mehr installiert. Die haben noch einen bitterbösen Brief von meinem Rechtsanwalt bekommen. Wenigstens die Kosten für de Proversion wurden erstattet.

Wie gesagt ganz früher war Avira mal gut. Haben dann aber extrem nachgelassen. Und die Unternehmen sind sowieso zu anderen Herstellern gegangen.

"Windows 11-Updates, die regelmäßig das Startmenü kaputt machen."

Nur Windows 11?

Ich kenne das sehr gut von Windows 10, man klickt drauf und es passiert – nichts –

Geradezu eine Wohltat hingegen wenn man mal wieder Gelegenheit hat ein Windows XP oder 7 in einer VM zu nutzen, wie schnell alles reagiert. Geradezu ohne Verzögerung.

Haftung bei Software ist da wichtig, wo diese Sicherheitskritische dinge ausführt. Dort wo Menschen durch Fehlfunktionen verletzt werden können. (Medizingeräte, Automatisierungstechnik, Fahrfunktionen in Autos, Stellwerke der DB, Tower auf dem Flughafen …)

Eine Firma sollte Updates erst von der IT testen lassen und anschließend freigeben. Damit sollte es eigentlich keine Produktionsausfälle geben. Ein Restrisiko (Crowdstrike problem) durch Software die sich selbst aktualisiert, wird immer bleiben.

Für meinen Multimedia PC zuhause, ist das nicht so wichtig. Wenn er nicht mehr läuft, muss ich halt das letzte Systemabbild wiederherstellen oder Windows reparieren.

Andererseits stellt sich die Frage:

Welcher Endanwender würde überhaupt einen Softwarekonzern verklagen. Zumal ein groß teil der Software die auf dem PC läuft, ja gar keine Bezahlversion mehr ist. Selbst Windows ist ja in dem vergangen Jahrzehnten zur Rauschware geworden.

Wenn Microsoft dafür wieder entsprechend Geld verlangen würde, dann würde ich auch eine Qualitätssicherung erwarten.

Die Windows 11 Lizenz auf meinem Zweit PC geht auf ein Windows 8 Upgrade Paket auf dem Mediamarkt zurück. Wenn ich mich recht erinnere hat das 39,99€ gekostet Das war 2012. Eine 2016 gekaufte Windows 8.1 Pro hat mich rund 120€ gekostet. Die läuft mittlerweile als Windows 11 25H2.

Windows XP Pro war da bedeutend teurer. Wenn ich mich recht erinner so um die 180€. Damals war der Euro noch entsprechend mehr wert.

16GB für 50 Tabs in Chrome würde ich nicht mal so schlimm finden. Das sind ja nur rund 330MB pro Tab. Mein Mozilla Firefox belegt momentan rund 3,9GB RAM für 19 Tabs (210MB je Tab).

Wenn der RAM bedarf weiter steigt, bekommt halt mein nächster PC 64GB RAM. Damit sollte es für das nächste Jahrzehnt wieder ausreichen.

Statt Geld bezahlst Du Microsoft & Co. inzw. mit Telemetriedaten aller Art und KI Futter…

Copilot benutze ich sogar manchmal. Hat mir schon bei der Lösung von Windows Problemen geholfen. Wenn er total falsch liegt, sollte man das Copilot auch mitteilen. Ohne konkret Korrektur angaben des Nutzers, wird Copilot nichts dazu lernen.

Konnte mir auch dabei behilflich sein, festzustellen, von welcher Position eine im Urlaub gekaufte Ansichtskarte von Betancuria aufgenommen wurde. (Habe sie eingescannt, und anschließend der KI bereitgestellt.) Mit weiteren Daten von der Ansichtskarte, konnte ich noch Informationen über das Aufnahmejahr und den Fotografen herausfinden.

1999 sah es da noch viel Grüner aus als 2025. Anschließend habe ich mit ihm noch über die Niederschlagsmengen der letzten 25 Jahre geschrieben. Er bestätigte mir, das es Jahr für Jahr auf Fuerteventura trockner wird. Die aussage deckt sich mit dem Informationen, die ein Reiseleiter bei einer Inselrundfahrt gegeben hat.

Mit Deinen Telemetriedaten aller Art und KI Futter hat die Nutzung von Copilot wenig zu tun, das Futter sind die Dateien in Onedrive & Co.

PS. Je nach Jahreszeit und Regentagen ist es auf Fuerteventura innerhalb von wenigen Tagen auch mal gut grün, das geht ganz schnell.