Verlernt eine ganze Generation an Schülern und Studenten die Fähigkeiten zum Lernen durch die sich jetzt abzeichnenden AI-Lösungen? Ich füge mal einige Informationssplitter rund um das Thema Lernen, Wissen und KI zusammen, die mir kürzlich untergekommen sind, in einem Artikel zusammen.

Verlernt eine ganze Generation an Schülern und Studenten die Fähigkeiten zum Lernen durch die sich jetzt abzeichnenden AI-Lösungen? Ich füge mal einige Informationssplitter rund um das Thema Lernen, Wissen und KI zusammen, die mir kürzlich untergekommen sind, in einem Artikel zusammen.

PIAAC-Studie: Gravierender Abfall der Lesekompetenz

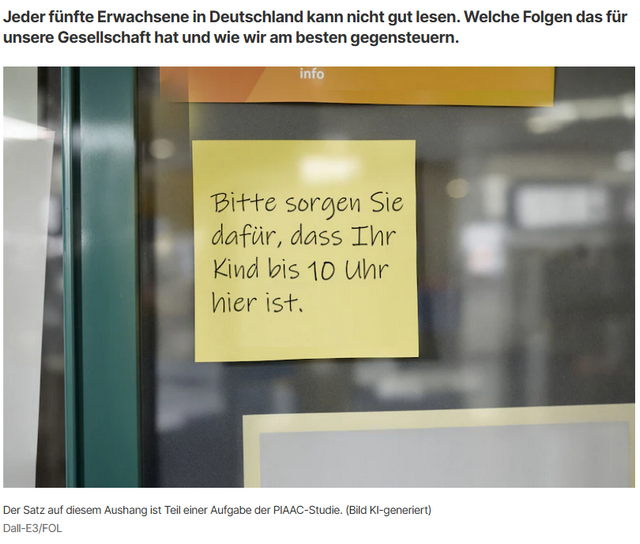

Es war eine erschütternde Information, die die neuste PIAAC-Studie (wohl noch aus 2023) ergeben hat. Die Studie führt eine Art Pisa-Test für Erwachsene durch. Untersucht werden Lesekompetenzen, alltagsmathematische Kompetenzen sowie technologiebasierte Problemlösungskompetenzen Erwachsener. In diesem Test wurde auch das Verständnis einzelner Sätze wie in nachfolgendem Bild gezeigt, und im Hinblick auf das Leseverständnis abgeprüft. Die Ergebnisse für Deutschland, Österreich und die Schweiz sehen nicht gut aus.

Quelle: Screenshot Focus Online-Artikel

Die Uni Hamburg hat in dieser Mitteilung von September 2025 einige Ergebnisse zusammen getragen. Eine Erkenntnis: Der Anteil von Menschen mit geringen Lese- und Schreibkompetenzen, die die Botschaft auf obigem Zettel nicht verstehen können, stagniert in Deutschland bei 20 Prozent. Das sind 10,6 Millionen Erwachsene zwischen 16 und 65 Jahren.

Der Focus hat das Thema dann in diesem Artikel aufgegriffen und verdeutlicht, dass jeder fünfte Erwachsene in Deutschland erhebliche Probleme hat, gelesenes zu verstehen. Für eine hochdifferenzierte und digitalisierte Gesellschaft ist das ein Problem. Der Umgang mit Künstlicher Intelligenz, das Erkennen von Falschnachrichten oder auch die Bewältigung alltägliche Aufgaben ist ohne Lesekompetenz praktisch unmöglich. Wenn wir aber bereits 20 % der Bevölkerung auf diese Weise verlieren, ist das ein riesiges Problem.

Studenten verlieren mit KI wichtige Fähigkeiten

Schauen wir nun auf den "oberen Anteil" unserer zukünftigen Eliten, die heute als Oberstufenschüler und Studenten die "Schulbank drücken". Lesekompetenz darf man da voraussetzen. Aber wie sieht es mit der Lernkompetenz und dem vertiefenden Wissenserwerb, der eine akademische Laufbahn auszeichnen sollte, aus?

Es ist eigentlich eine alte Erfahrung: Man erlernt etwas nur durch Üben – das ist beim Spielen eines Musikinstruments, beim Programmieren, beim Fliesen-Legen, oder eben beim Lernen der Fall, wie vermutlich jeder aus der Leserschaft bestätigen kann. Die Älteren kennen vielleicht noch die Technik, sich etwas aufzuschreiben. Alleine dadurch bleiben Lerninhalte länger präsent und sitzen irgendwann. Hausarbeiten sollen die Möglichkeit geben, das Wissen zu erarbeiten und zu vertiefen.

Und es gibt die Erfahrung, dass Fähigkeiten auch verloren gehen, wenn sie nicht mehr gefordert werden. Ich denke gelegentlich arg frustriert daran, wie gut ich mal in Integral- und Differentialrechnung, im Lösen von Differentialgleichungen, in Physik und Elektrotechnik war.

Aber das Wissen habe ich seit 1979 – quasi 46 Jahre lang – praktisch nicht mehr benötigt, und alles ist weg. Mir ist aber auch noch der Spruch meiner Lehrer auf dem Weg zur Fachhochschulreife im Ohr: "Ihr müsst nicht selbst alles wissen, aber ihr müsst wissen, wo etwas steht und wie ihr euch dieses Wissen schnellstmöglich aneignet". Zur Aneignung des mathematischen Wissens währen heute bei mir erhebliche Anstrengungen erforderlich, da auch die Basics verlernt wurden.

Szenenwechsel: Anfang November 2025 bin ich bei The Register auf den Artikel mit dem bezeichnenden Titel Students using ChatGPT beware: Real learning takes legwork, study finds gestoßen. Wissenschaftler haben eine Reihe von Experimenten mit mehr als 10.000 Teilnehmern durchgeführt. Mit denen Experimenten sollte ermittelt werden,

- wie sich das Verständnis der Menschen für ein Thema unterscheidet, wenn diese vorgefertigte Zusammenfassungen von KI-Chatbots verwenden,

- oder wenn die Vergleichsgruppe, die Online-Informationen die durch traditionelle Websuchen finden mussten, unterscheiden.

The Register fasst die Erkenntnisse der in PNAS erschienenen Studie (ähnliches gibt es auch aus einer US-Studie an Oberstufenschülern) so zusammen: Teilnehmer, die ChatGPT und ähnliche Tools verwendeten, entwickelten ein oberflächlicheres Verständnis des ihnen zugewiesenen Themas als Teilnehmer, die selbst die Online-Informationen suchen mussten. Die ChatGPT & KI-Nutzer konnten auch weniger konkrete Fakten liefern und neigten dazu, ähnliche Informationen wie andere Teilnehmer wiederzugeben, die KI-Tools verwendet hatten.

Die Forscher zogen aus den Experimenten den Schluss, dass große Sprachmodelle (LLMs) zwar flüssige Antworten quasi auf Knopfdruck auszuspucken. Aber Menschen, die sich bei ihrer Recherche auf synthetisierte KI-Zusammenfassungen verlassen, erwerben in der Regel kein wesentlich tieferes Wissen.

Die eigentlich zu erwartende Erkenntnis lautete: Nur wenn Menschen selbst in Quellen recherchieren und Informationen zusammenstellen, bauen sie in der Regel ein nachhaltiges Verständnis auf, welches dann auch den Leuten erhalten bleibt. Es ist die alte Erkenntnis: Wissen muss mühsam erarbeitet werden, in Schule, Studium und Beruf.

Die Vorstellung, das quasi auf Knopfdruck an ChatGPT & Co. auszulagern, wird keine "Experten" hervorbringen. Um ein Experte auf einem Gebiet zu sein, muss man Zeit mit Pauken verbringen. Die Forschung untermauert die wachsenden Bedenken hinsichtlich der Zuverlässigkeit von KI-generierten Zusammenfassungen.

Die akademische ChatGPT-Falle

Gerade Studenten sollen ja den Erwerb des Wissens lernen und das auch in Projekten oder Ausarbeitungen demonstrieren. Da ist oft die Versuchung groß, eine Studienaufgabe an ChatGPT auszulagern. Zu meiner Schul- und Studienzeit gab es noch kein ChatGPT & Co., sondern höchstens den "guten Freund, der wusste, wie etwas geht". Ich erinnere mich an zwei Fälle, in denen Mitschüler und Kommilitonen aufgeflogen sind, weil sie krachend dämlich waren. Eine in einer Studienarbeit gestellte Aufgabenstellung musste schriftlich als Projekt ausgearbeitet und abgegeben werden. Eine Studienarbeit bestand in der Lösung einer Programmieraufgabe in Fortran. Ein Oberschlauer reicht dann seine "Studienarbeit" beim Professor ein, hatte aber nicht gerafft, dass sein Kumpel das Ganze in BASIC verfasst hatte. Der Professor war "not amused" und ließ den Kerl glatt durchfallen – und das mit Recht. Gut, die Ingenieure und Naturwissenschaftler kriegt man schnell wegen Schummelns an den Hammelbeinen. Bei Geisteswissenschaftlern und Juristen geht es eher um die "Kunst der Formulierung und Argumentation".

Kurz vor dem Verfassen dieses Beitrags bin ich über Facebook auf obigen Post gestoßen. Ein Professor baute in seine Studienprojekte eine Falle ein, die Studenten aufliegen ließ, wenn diese mittels AI zu betrügen versuchten. Der Mann schreibt hier: "Seit dem Frühjahrssemester 2023 ist zu beobachten, dass immer mehr Studierende mit KI erstellte Arbeiten einreichen. Ich bin es gewohnt, dass Schüler versuchen, sich durch Kopieren und Einfügen aus Wikipedia zu behelfen, aber die Einführung generativer KI hat ihnen völlig neue Möglichkeiten zum Schummeln eröffnet."

Plagiatsdetektoren sind schlecht darin, KI-generierte Arbeiten zu erkennen, heißt es. Aber der Professor wollte genauer schauen, ob KI-generierte Inhalte unerlaubt als Hausarbeiten eingereicht wurden. Einige Arbeiten seien durch den von ChatGPT verwendeten Stil (als seelenloses, langweiliges Gräuel mit Phrasen angereichert bezeichnet) leicht zu erkennen, heißt es.

Es bestehe jedoch ein Unterschied zwischen dem Erkennen der Verwendung von KI und dem Nachweisen ihrer Verwendung. Also hat der Professor ein Experiment versucht, und eine Art "Trojanisches Pferd" in die gestellten Aufgaben eingebaut, um den Betrug durch die Verwendung von KI-Lösungen in den Hausaufgaben nachzuweisen.

In einem Überblickskurs für Studienanfänger lautete die Studienaufgabe einige der Hauptpunkte des Autors eines vorgegebenen Buches zu beschreiben. Von 122 eingereichten Studienarbeiten identifizierte das Trojanische Pferd mühelos 33 als von KI generiert. Der Professor gab allen Studierenden die Möglichkeit, die Verwendung von KI zuzugeben, bevor sie durch Nichtbestehen der Vorlesung bestraft wurden. Darauf gaben weitere 14 Studenten sich selbst zu erkennen. Das bittere Fazit: Fast 39 % der eingereichten Arbeiten waren zumindest teilweise von KI geschrieben worden. Mit anderen Worten: Da wächst die nächste Generation der Blender und nicht Wissenden heran, die die Gesellschaft die nächsten 30 Jahre tragen und weiter entwickeln soll. Keine berauschenden Aussichten – und nichts, was sich in den Hochglanz-Marketing-Broschüren der KI-Verfechter so findet.

MVP: 2013 – 2016

MVP: 2013 – 2016

Danke an den Autor für das Verlinken des Quellartikels in der HuffPo. Der ist hoch spannend. Ich war erst skeptisch, aber der Prof scheint wirklich zu wissen, was er da tut.

Leider wird der Trick wahrscheinlich nur ein einziges Mal funktionieren und ist auch eher eine Lehrstunde in "input sanitation", aber wer weiß, ein paar Unbelehrbare wird es auch in Zukunft geben.

Erschreckend und einleuchtend finde ich auch die Aussage des Profs, dass viele Studenten sich garnicht bewußt waren, dass das Verwenden eines Textgenerators zum Schreiben einer Hausarbeit eine Form von Betrug ist. Sie bekommen es ja tagtäglich von allen (medialen) Seiten eingetrichtert, dass "die KI" ja alles kann und die Zukunft ist.

Und bitte verzeiht mir abschließend meinen Zynismus, als einer der letzten Jahrgänge, die noch "auf Diplom" studieren konnten: Was erwarten wir denn auch was passiert, wenn wir den nachfollgenden Generationen nun schon seit gut 2 Jahrzehnten beibringen, dass Bildung und Wissenserwerb keinen inheränten gesellschaftlichen Wert hat, sondern dass es nur um den möglichst schnellen Erwerb möglichst vieler "ECTS-Points" geht, damit man nachher einen Abschluss hat, weil ohne ist man ja nichts. Klar, dass dann das Kosten/Nutzen-Verhältnis optimiert wird.

Als auch Inhaber eines Universitäts Diploms kann ich das nur bestätigen. Es war ein steiniger und langer Weg dorthin, doch zahlt sich das heute 40 Jahre später immer noch aus. Wenn ich schon sehe, daß sich Menschen ohne Schulabschluß auf ein duales Hochschulstudium bewerben.Die Ära der deutschen Wissenschaft und Ingenieurskunst geht zu Ende. Mit Bachelor Studiengängen hat es anefangen und die KI versetzt dem universitären Bildungswesen vollends den Todesstoß. KI ist nicht mehr als Spielkram und noch nicht mal intelligent. Mir reicht meine natürliche, menschliche Intelligenz aus, ich brauche keine KI und lehne das ab.

+ Betr. "Als auch Inhaber eines Universitäts Diploms …":

Das ist nicht das Deutsch eines Universitätsabsolventen.

+ Betr. "daß sich Menschen ohne Schulabschluß auf ein duales Hochschulstudium bewerben.":

Da mal bitte ein Beispiel, einen Beleg.

+ Betr. "Die Ära der deutschen Wissenschaft … geht zu Ende."

Deutsche Wissenschaft, was soll das sein? Etwa Deutsche Physik (1) oder Deutsche Mathematik (2)? Die waren aber schon spätestens 1945 am Ende.

–

(1) https://de.wikipedia.org/wiki/Deutsche_Physik

(2) https://de.wikipedia.org/wiki/Deutsche_Mathematik

>>> Sie bekommen es ja tagtäglich von allen (medialen) Seiten eingetrichtert, dass "die KI" ja alles kann und die Zukunft ist.

>>> a wächst die nächste Generation der Blender und nicht Wissenden heran, die die Gesellschaft die nächsten 30 Jahre tragen und weiter entwickeln soll

Genau das hätte ich vermutet. Die wissen gar nicht was sie da tun. Die sehen das Werkzeug an und benutzen es. Und man darf wirklich nichts erwarten, wenn heute in den Schulen alles leichter ist, weil dort Technik erlaubt ist, wo es das früher nicht war. Damit meine ich bereits Taschenrechner. Schule sollte sagen wir bis zur 8 Klasse vollständig analog stattfinden ohne digitale Medien/Technik als Hilfsmittel.

Aber auch zu meiner Studienzeit gab es genug Leute die ein Ingenieursstudium begonnen haben und bereits an einer Geradengleichung gescheitert sind, obwohl das wenige Wochen zuvor in der Schule noch Stoff gewesen ist. Die hätten also die Hochschulreife niemals erhalten dürfen, denn sie waren nicht reif für die Hochschule. Abi und Fachabi haben nicht mehr die Filterwirkung für die sie einstmals erdacht wurden. Da ist Dreh- und Angelpunkt für unsere Bildungselite – Schule muss wieder Filtern – das ist eine ihrer Aufgaben – aber genug Menschen sehen das heutzutage anders und haben gar nicht das mentale Niveau um zu verstehen was sie damit langfristig anrichten.

Wer wirklich reif für die Hochschule ist, der wüsste auch wie und wo er KI als Werkzeug unterstützend sinnvoll einsetzen kann und wo nicht.

Bei Abi und Fachabi gibt es immer Leute, die keine Ahnung haben und trotzdem da sehr gute Noten bekommen.

Ich hatte in meiner Schulklasse so jemanden:

Der hatte immer gute Noten, aber wissen tat er nichts.

Er hat immer gezielt für Klassenarbeiten und Prüfungen gelernt, dann dort gute Noten kassiert und danach hat er das Wissen, das er sich für die Klassenarbeiten und Prüfungen angeeignet hat, sehr schnell wieder vergessen.

Und solche Leute schaffen es mit dieser Methode auch durchs Studium und Prüfungen.

In der Firma hatten wir auch so einen Fall:

Einen Mann eingestellt, der einen Meisterbrief mit guter Note hatte.

In der Praxis hat sich dann gezeigt, das dessen Wissen und Fähigkeiten höchstens denen eines Azubis im 2. Lehrjahr entsprechen.

Ergo durfte der Mann noch in der Probezeit wieder gehen.

Ich habe schon seit vielen Jahren den Eindruck, das das Bildungsniveau allgemein sinkt.

IMHO hätte jemand, der 2010 sein Abitur machte, kaum ein Abitur von 1980 geschafft.

Man schaue sich nur einmal die Verteilung zwischen den Schulzweigen Hauptschule, Realschule und Gymnasium an.

Immer mehr Schüler machen Abitur oder Fachhochschulreife, der Anteil der Realschüler und Hauptschüler sinkt stetig.

Bei den 25-34 jährigen haben satte 57% Abitur oder Fachhochschulreife und nur 12% einen Hauptschulabschluss.

Bei den 55-64 jährigen haben nur 33% Abitur oder Fachhochschulreife und 25% einen Hauptschulabschluss.

IMHO ist das nicht so, weil die Schüler schlauer werden, sondern weil die Anforderungen an den Abschluß stetig schwächer werden.

Das sieht man ja auch an der regelmäßigen PISA-Studie, bei der deutsche Schüler regelmäßig ziemlich schlecht abschneiden.

Das passt nur zu dem hohen Anteil an Abiturienten, wenn das Anforderungsniveau sinkt.

Und die "KI" wird das noch befeuern.

Ich habe auch ein Diplom und kann noch Google benutzen ;)

Jaja, man lacht – aber nicht mehr lange…

Den folgenden Witz kannten wir bereits in den späten 80ern (mit anderen Jahrenszahlen und ohne diverse Ergänzungen), aber er ist wohl immer noch aktuell:

"https://www.programmwechsel.de/lustig/humor/mathematik-im-wandel-der-zeiten.html"

das Sprachverständnis ist teilweise schon erschreckend schlecht, dabei wäre in einer komplexer werdenden Welt das Gegenteil notwendig: sprachliche Präzision wird umso wichtiger, je komplexer Aufgaben und Prozesse im Arbeitsalltag werden.

Was Lernen betrifft: absolut korrekt, die Basics verstehen und anwenden, wiederholen, die key facts rausschreiben und bei Bedarf wieder sichten, über die Jahre Details vertiefen. Es is so einfach, scheinbar zu einfach, denn man wundert sich, warum das so wenige verinnerlichen.

Im Prinzip ja, dann aber bitte auch "Grundlagen" anstelle von "Basics" schreiben und "wesentliche Fakten" anstelle von "key facts". Mit Denglisch geht es nämlich los Sprache aufzuweichen und – ja – mit Gendern – versetzt man einer Sprache TECHNISCH(!) den Todesstoß (Sofern eine Sprache das nicht schon von sich aus mitbringt – soll es ja geben). Das moralische am Gendern lassen wir mal weg.

Moral hat jeder seine eigene aber damit eine Sprache funktioniert muss sie technisch funktionieren was im Deutschen durch Gendern nicht mehr der Fall ist. Deutsch wird durch Gendern einfach grammatikalisch falsch und Sinnentstellend.

Darf man sich also nicht darüber wundern, wenn der Nachwuchs gar nicht mehr weiß was Sache ist und sich verwirrt den Kopf daher lieber mit Drogen und TikTok "wegballert".

p.s. Allerdings hat Gendern und neue Rechtschreibung auch sein Gutes! Menschen wie ich die mit Sprachen auf Kriegsfuß stehen, können so falsch schreiben wie sie wollen und einfach behaupten: "Das ist neuerdings so korrekt" :)

Ist insgesamt eine schwierige Kiste mit Sprache: sprechend und schreibend. Hier einfach einige Gedankensplitter dazu von meiner Seite als Autor.

* Als das mit dem Gendern anfing, habe ich der Sache eigentlich neutral gegenüber gestanden. Da war die Überlegung "dir bricht kein Zacken aus der Krone, wenn Du die weibliche Seite mit berücksichtigst". Habe ich genau drei Wochen hier im Blog durchgezogen und dann das Gendern mit Sternchen eingestellt. Warum? Weil die Texte sprachlich verhunzt und kaum noch verständlich waren. Ich schreibe daher schon mal in einem Eingangssatz "an die Leserinnen und Leser", um beide Geschlechter aus Höflichkeit und Wertschätzung anzusprechen. Aber wenn ich heute eine gegenderte Pressemitteilung auf den Tisch bekomme, ist die Chance hoch, dass die unter den Tisch fällt – weil mir der Aufwand zum "Entgendern" schlicht zu hoch ist.

* Zum Denglish: Ist auch eine schwierige Kiste – hier im Blog sind wir stark IT-technisch behaftet. Daher bevorzuge ich i.d.R. die englischen Begriffe, weil das klarer wird. Ich erinnere mich als junger Ingenieur mich mit Intel Mikroprozessor-Programmierung auf sehr tiefgehendem Niveau (um Interrupt-Controller anzusteuern und Routinen zur Interrupt-Behandlung, zum Ansprechen von Timern und UART-Bausteinen etc. in Assemblercode zu implementieren) befasst zu haben. Ein älterer Kollege meinte "Da hast Du die Dokumentation" und stellte mir einen Meter Siemens Handbücher auf den Schreibtisch. War Intel-Dokumentation 1A in deutsche Sprache übersetzt, aber ich habe gelesen und gelesen, und nur Bahnhof verstanden. Nach zwei, drei Stunden bin ich frustriert aufgestanden und durch die Nachbar-Büros gelaufen und habe gefragt, ob jemand die Original-Dokumentation von Intel auf Englisch habe. Ein Kollege meinte "da hinten steht der Intel-Dokumentationssatz in den blauen Ordnern, kannst Du dir gerne ausborgen, die schaut von uns eh keiner an". Gut, die meisten der Leute waren Techniker und deutlich älter als ich. Ich habe mir die Intel-Ordner gegriffen, immer jeweils den benötigten Abschnitt kurz durchgelesen, und wusste, worum es geht. Auflösung: Die Siemens-Übersetzer hatte alle Fachbegriffe wunderbar mit ins Deutsche übersetzt, weshalb ich nur Bahnhof verstand (im Studium und danach hatte ich immer nur die englischen Begriffe gehört).

Die beiden Informationssplitter zeigen, dass da durchaus einiges bedacht sein will, wenn man etwas mehr schreibt. Und wenn Du dann noch in ein Corporate Identity -Korsett gezwängt wirst, wird es noch komplexer. Gab mal Zeiten, wo ich für Microsoft Press Deutschland US-Bücher übersetzt habe. Waren aber auch noch die Zeiten, wo in den USA die deutschen Leute, die für die Lokalisierung zuständig waren, bei den Übersetzern und Autoren nachgefragt haben, wie man diesen und jenen Begriff lokalisieren und in das Übersetzerwörterbuch übernehmen soll.

Ahhhhhh, die deutschen Handbücher für IT, einfach schmackhaft.

Hatte vor Jahren einen IT-Lehrer am Berufskolleg der ALLES verdeutscht hat, und auf den Gebrauch von deutschen Bezeichnungen bestanden hat. Ob sich mal Schüler über seine englische Aussprache lustig gemacht haben oder wieso genau… K.A. ¯\_(ツ)_/¯

Feld, Zeiger, Schwebende Zahl, Lange Zahl, Ganzzahlwert, Namensraum, Pufferüberläufe, Boolescher Wert, Haldenspeicher etc.etc.etc

Lustiger weise tauchen diese begriffe jetzt vermehrt auf, wahrscheinlich wegen KI-Übersetzungen…

Und dann gibt es so Stilblüten bei der Übersetzung von Oberflächen der Hersteller, wo man sich auch erst mal fragt: Bitte was? Meine Highlights sind nach wie vor der Begriff "Schalter" für einen Switch und die "Tatsächliche Größe". Bei letzterem war in einem Managementsystem eines Drittanbieters die Videokonferenzausrüstung des Herstellers "LifeSize" gemeint. Aber Firmennamen kann man mal so mit übersetzen.

Oder auch mal Fehlermeldungen, die einfach auf Deutsch gar keinen Sinn ergeben, weil vermutlich irgendwer den Text der Originalsprache über den Google Übersetzer geschubst hat.

Und was das "Gendern" angeht. Zumindest für den Browser habe ich mir die Erweiterung "Binnen-I Be Gone" installiert, die filtert das sehr zuverlässig raus und macht die Texte wieder vernünftig lesbar.

>>> Zum Denglish: Ist auch eine schwierige Kiste – hier im Blog sind wir stark IT-technisch behaftet. Daher bevorzuge ich i.d.R. die englischen Begriffe, weil das klarer wird.

Interessanterweise würde ich das nicht als Denglisch bezeichnen sondern als Gebrauch von Fachwörtern. Die Amis haben im US Englischen z.B. wohl kein Wort für Kindergarten – also schreiben sie schlicht "Kindergarten".

Im Eingangspost, sehe ich das anders. Da wäre Basics richtigerweise als Grundlagen zu schreiben gewesen. Da war es nur "Denglisch" und nicht mal fachlich auf IT bezogen wie es hier im Blog selbstverständlich ist/wäre.

Und das ist "nur" Denglisch. Wie geschrieben: Schlimm wird es wenn der Sinn entstellt wird und das ist bei vielen gegenderten Begriffen der Fall. Vom Lesefluss noch gar nicht gesprochen…

Die Diskussion ist alt.

Die Schreibmaschine.. der Taschenrechner.. die Textverarbeitung.. die Rechtschreibprüfung.. Wikipedia.. jetzt eben neu .. die KI

Jeder Lehrer der ab und zu mit den Schülern/Studenten spricht, weiss sofort wo diese stehen.

richtig er hat aber nix mehr zu melden… wenn den Eltern die Einstufung ihrer Rotznasen nicht passt wird eben geklagt.

Der Bengel ist zwar zu blöd um gerade zu Scheißen, aber er muss aufs Gymnasium!

Von jeder der von der Begabung zum Studium befähigt ist sollte auch studieren können und nicht daran scheitern das die Eltern sich das leisten können… zu jeder muss studieren können, egal was für ne Flachpfeife er ist!

Und wenn PISA & Co. da die Lücken aufdecken, schraubt man halt das Niveau runter damit der Notendurchschnitt wieder passt!

Ich stelle grundsätzlich keine Bachelor ein, Master ist Pflicht! Da siebt man die Spreu dann gleich aus.

Bei der Rechtschreibung würde ich dich auch nicht einstellen, vom Tonfall her ganz zu schweigen.

Lass mich raten, Baumschulabschluss und auch noch stolz drauf?

Man muss halt wissen wann es drauf ankommt und wann nicht ;-P

Sorry nen Blog/Forenpost ist keine Bewerbung.

/edit/

Und nein, da liegst du falsch, ich habe sogar mehrere Abschlüsse! Von ganz unten nach ganz oben. Stolz? Es gibt einiges, auf das ich stolz bin, das gehört aber nicht dazu, denn das ist lediglich Fleiß!

Ansonsten: Icke bin Icke und ich verbieg mich für niemanden, ich sage, was ich denke. Muss dir nicht gefallen, aber das ist dein Problem, nicht meins.

Fachinformatiker der ersten Generation sind häufig richtig gut. Die würde ich jederzeit einem Dipl.-Inf./Master-Informatik vorziehen – selbst wenn der noch einen Prof. Dr. an seinen Master angehängt hat.

Wie war das mit dem Glashaus?

Auch die Zeichensetzung ist wichtig!

Beispiele:

Komm, wir essen, Opa.

Komm, wir essen Opa.

Ein kleines Komma entscheidet darüber, ob Opa aufgegessen wird oder nicht!

Oder zum Thema Bildung:

Manche Lehrkräfte sagen, Schülerinnen und Schüler seien nicht mehr das, was sie einmal waren.

Manche Lehrkräfte, sagen Schülerinnen und Schüler, seien nicht mehr das, was sie einmal waren.

Eine völlig andere Bedeutung, nur weil die Kommas anders gesetzt sind.

Oder:

Die Lehrerin rät, Lina nicht immer alles zu erzählen.

Die Lehrerin rät Lina, nicht immer alles zu erzählen.

Die Lehrerin rät Lina nicht, immer alles zu erzählen.

Die Lehrerin rät Lina nicht immer, alles zu erzählen.

4 verschiedene Bedeutungen nur durch die Zeichensetzung.

Rechtsschreibung in Foren, Blogs etc. geht mir ehrlich am Arsch vorbei… solange der Sinn bestehen bleibt ;-P

Gibt eben wichtiges und unwichtiges…

Das ist aber doch das Entscheidende – der "Sinn" bleibt eben nicht erhalten und die Wenigsten verfügen über hellseherische Fähigkeiten und können den vom verfassenden Absender intendierten "Sinn" entsprechend auffassen bzw. interpretieren, woraus sich auch vielerlei zu beobachtende Mißverständnisse zeigen! 🤷♂️

Und evtl. hat's auch ganz stumpf etwas mit ein wenig eigenem Respektsverhalten dem Gegenüber zu tun – man muß sich ja nicht unabdingbar zwingend auf gleichem Niveau bewegen. 😉

Wir haben das "Beste Netz" sagt der Provider!

Paula, Elfriede und Conny schreiben ein Deutsch Diktat. Paula und Elfriede erhalten eine Sechs, Conny eine Fünf. Conny ist mit Fug und Rechte die Beste Schülerin unter den dreien. Eine gute Schülerin ist sie nicht.

Soviel zur Werbung mit dem "Besten Netz".

Also liebe Provider – das beste Netz könnt ihr behalten. Wenn ihr aber ein "Gutes Netz" habt, dann meldet euch!

Ja, aber Sinnentlehnung mußt Du doch nicht mir beschreiben/erklären, gell?! 😉

Nö, lesen aber noch andere mit oder nicht?

Beste Grüße!

Also ich sehe jetzt nicht wo eine Kommasetzung meinen Ausgangspost den Sinn verändert! Ich gebe dir durchaus recht solche Fälle gibt es durchaus.

Studien haben eindeutig ergeben: Das menschliche Gehirn ist genial, es kann Wörter sogar noch erkennen wenn man Buchstaben weglässt oder die Reihenfolge ändert.

***********************************************

Gmäess eneir Sutide eneir elgnihcesn Uvinisterät ist es nchit witihcg, in wlecehr Rneflogheie die Bstachuebn in eneim Wrot snid, das ezniige, was wcthiig ist, ist, dass der estre und der leztte Bstabchue an der ritihcegn Pstoiion snid. Der Rset knan ein ttoaelr Bsinöldn sien, tedztorm knan man ihn onhe Pemoblre lseen. Das ist so, wiel wir nciht jeedn Bstachuebn enzelin leesn, snderon das Wrot als gseatems.»

****************************************************

Leute dessen Gehirn das nicht verarbeiten können haben eine Störung.

"Leute dessen Gehirn das nicht verarbeiten können haben eine Störung."

Stammt diese Aussage von Dir oder von jenen "Studienverfassern"?

Btw.:

In Deinem Satz gibt's leider nicht nur Interpunktionsfehler. 😉

Geil – LoL!

Die Beispiele habe ich mir gleich notiert. Die gebe ich bei Gelegenheit der Person mit, die mir ihren Text ständig in Kleinbuchstaben und ohne Kommas schickt. Meine Kritik zu dieser Schreibweise war wohl nicht so einleuchtend wie bei diesen Beispielen. Zumindest schreibt die Person jetzt nicht mehr alles in Großbuchstaben. Das war sonst immer wie das Entschlüsseln von Hieroglyphen, nur nicht mit der Begeisterung eines Forschers!

Achso, der Grund für diese Schreibweise war, dass sie nie genau wusste wo, bzw. wann man Kommas setzt. Gleiche Unklarheit bei Großschreibung, wenn nicht am Satzanfang.

Deshalb ließ sie alles weg.

Zur Kleinschreibung passt dann dieses Beispiel:

"Ich habe liebe Genossen" (eine eher im linken Politiksprektrum vorkommende Aussage über Kollegen) vs.

"Ich habe Liebe genossen" (schön für den der das sagen konnte)

Ich würde sagen, dass die schulischen Leistungen zweitrangig sind. Entscheidend ist, ob er Talent für die Tätigkeit hat, die er ausüben will.

Ich gebe auch Seiteneinsteigern eine Chance, dafür gibt es die Probezeit einem zu überzeugen. Bei Spar-Diplom Bachelor bin ich jedoch eisern: No Chance! Einfach aus Erfahrung.

Hmm…obwohl diese Verfahrensmethode Dir natürlich unbenommen bleibt, wirkt sie allerdings i-wie schon auch ein wenig "diskriminierend" begrenzend – es könnten Dir so durchaus auch talentierte sowie engagierte "Juwele" entgehen. 🤷♂️

Mal nur so als Gedanke:

Jemand lernt den Job von der Pike auf und arbeitet viele Jahre in der Branche und entschließt sich dann i-wann doch noch nachträglich für 'ne akademische Qualifikation.

Muß die zwingend unabdingbar mit dem höchsten Grad abgeschlossen sein, um bei Dir Vertrauen in die fachlichen Qualitäten zu erwecken?

Das hat auch durchaus seine Gründe.

Beipielsweise Taschenrechner:

Der Gebrauch eines Taschenrechners war auf meiner damaligen Schule erst ab der 7. Klasse erlaubt.

Und man hat damals auch noch Kopfrechnen gelernt.

Z.B. das kleine Einmaleins musste man wie aus der Pistole geschossen beherrschen.

Heutzutage holen die Schüler ja schon bei z.B. 7×8 den Taschenrechner hervor.

Zu meiner Schulzeit gab es keine Taschenrechner, die kamen erst auf, als ich im zweiten Lehrjahr war.

Die waren grundsätzlich nicht erlaubt da es zu meiner Schulzeit im Osten um 1967-1977 noch sehr wenige überhaupt davon gab (außer es war einer im Paket von der Verwandtschaft aus dem Westen, war ja der Klassenfeind, konnte ja nicht gut sein)

In der Lehre wurden Volumenströme und Rohrdimensionen mit dem Rechenschieber berechnet (rund eine DIN-A4-Seite pro Aufgabe)

So eine ähnliche Diskussion gabs letztens beim Cloudflare-Ausfall, weil da auch ChatGPT nicht funktionierte:

https://www.heise.de/forum/heise-online/Kommentare/Cloudflare-Ausfall-Dienste-am-Dienstag-global-gestoert/Direkt-beobachtete-Auswirkungen/posting-45738868/show/

Ich fand erschreckend, dass einerseits die Schule die Anwendung anscheinend toleriert – damit untergräbt sie ihren Bildungsauftrag. Fast noch erschreckender war, wieviele Leute das unterstützen. Die haben alle (meiner Meinung nach) den Sinn von Schule nicht verstanden.

Ja, auch ich habe im Abi Hilfsmittel wie einen 'Pocket Computer' (das war ein in Basic programmierbarer Taschenrechner) genutzt. Nur hatte ich die genutzen Programme selbst geschrieben und mich daher mit der Materie auch intensiv beschäftigt (was der Lehrer auch abgefragt hat).

Aber die fertige Lösung aus dem ChatGPT-Automat ohne Einsatz eigenen Hirns? So verblödet man, und das ist nicht Sinn der Schule.

Manchmal bekommt man den Eindruck, dass das Ziel der Bildungspolitik eher in Richtung – sagen wir mal – nicht so sehr hinterfragende Schüler geht, die kann man dann später im Wahlalter besser für die eigenen Ideen vereinnahmen.

An anderer Stelle hier im Blog konnte man lesen, dass Wahrheit ist, was in der Schule vermittelt wird.

Kein Scherz.

Ja leider gibt es viele verschiedenen Wahrheiten. Darum besser nach der Realität fragen, die lässt sich wenn überhaupt nur mit Drogen verdrehen und bleibt dann trotzdem wie sie ist.

Nein, es gibt nur eine echte wahre Wahrheit, nämlich die, die halt wahr ist; Realität ist nur ein anderes Wort dafür.

Was in der Schule (und von anderen Gatekeepern) gelehrt wird sind Interpretationen, die manchmal grob entstellend, manchmal mit subjektivem Kontext angereichert, manchmal schlicht gelogen sind. Das Problem ist eher, dass es keine verlässliche Instanzen mehr gibt – oder vielleicht auch nie gab, sondern immer nur Versuche, Herrschaft auszuüben. KI bricht das insofern auf, als dass sie ungewollt einen Spiegel geschaffen hat der uns zwingt, uns Kompetenz anzueignen, mit Informationen und "Autoritäten" richtig umzugehen. Das war einfach, als alle Leute nur entweder drei oder acht Finger auf Deepfakes hatten und in jedem Text echte Spiegelstriche auftauchten, die von KI produziert wurden.

Deshalb IMHO auch die Abneigung der klassischen Medien gegenüber KI – sie ist ein neuer Spieler auf dem Feld und muss bekämpft werden: Man kann quasi die Ontogenese der Medien im Zeitraffer beobachten und das deckt auf, was Medien seit Jahrzehnten perfektioniert haben.

Dazu kommt noch, dass KI aufdeckt, dass Wissen häufig nur rezipiert, aka nachgeplappert, wird, anstatt neues Wissen zu schaffen.

Ich lehne mich mal weit aus dem Fenster und mutmaße, dass KI das Ende der Laberwissenschaften sind, denn gut klingende Texte kann auch ein LLM generieren, dazu brauche ich keinen trainierten Marxisten/Feministen mehr, offensichtlich. Wer seine Daseinsberechtigung aus schönen Texten[tm] ableitet, wird eine harte Zeit haben, wenn rauskommt, dass es nur schöne Texte sind, die auch ein Taschencomputer erstellen kann. Grievance Studies Affair, als Stichwort.

Der Versuch von Teague hat es ja gezeigt: Hier werden Rituale vollzogen, anstatt Wissen zu schaffen. Schüler/Studenten schreiben, was ihre Lehrer hören wollen. Lehrer bestrafen, was sie nicht hören wollen. Erkenntnis gibt es dadurch aber nicht. Und es gibt nicht mal Übung, denn eigentlich ist klar, wie man eine gute Note bekommt: Man schreibt halt eloquent das, was der Lehrer irgendwie erwartet. Das entwertet in erster Linie den akademischen/intellektuellen Mittelbau.

Ähm, WO schafft KI – die diese Bezeichnung ja gar nicht verdient – NEUES Wissen?

>>> Nein, es gibt nur eine echte wahre Wahrheit, nämlich die, die halt wahr ist; Realität ist nur ein anderes Wort dafür.

Du weißt das, ich weiß das, diejenigen die ihre "eigene" Wahrheit haben bringt man mit dem Begriff Realität ins Wanken ;)

> dass KI das Ende der Laberwissenschaften sind

Das würde mich sehr freuen :D

Jo…gab's auch gestern 'ne interessante Reportage von und mit Linda Zervakis "Dumm, dümmer, Deutschland? Raus aus der Bildungskrise!" bei Pro7 zu – was soll man sagen…? 🤷♂️

Ja, habe ich zufällig während eines Besuchs bei Freunden auch gesehen. Die waren nicht gerade begeistert, aber nicht vom Inhalt der Reportage, sondern weil ich darum gebeten habe noch nicht umzuschalten! -LoL

Auch das hat mich zum Nachdenken gebracht.

Ich schaue normalerweise keine Privaten (eigentlich allgemein nicht viel Fernsehen), da dort meist nur Schrott läuft.

Ich war sogar entsetzt, als dort am Schluss der Werbeunterbrechungen Vorschauen auf manche Sendungen auf "Joyn" (kenne ich gar nicht) gezeigt wurden. Da wurden kurze Clips einer Art "Big Brother" Sendung gezeigt, nur noch hemmungsloser und frivoler mit viel "ASSI-Substanz".

Zieht das wirklich Zuschauer an? Das ist ja unglaublich!

Zurück zur Reportage "Dumm, dümmer, Deutschland? Raus aus der Bildungskrise!"…

Ich bin der Meinung, dass das Model aus Estland überzeugt!

Gleichzeitig lässt es einen verzweifeln, wenn man bedenkt (meine Vermutung), dass ein Gesinnungswandel, wie er in Estland etabliert ist, zunächst mal Generationen benötigen wird um bei uns Früchte zu tragen.

Na ja, sowas ist natürlich in einer Nation mit nur ca. 1,5 Mio. Einwohnern leichter zu "installieren", als bei über 80 Mio., von denen etwas über 10% eben lobbylose Nichtwahlberechtigte sind.

Und "Gesinnungswandel" beim noch mit dem Fax verhafteten Deutschen? Herrje…man sieht ja, das auch fast ein Vierteljahrhundert PISA dsbzgl. nichts bewirkt hat.

Btw.:

"Big Brother" und diese ganzen "Volksberuhigenden" Sendungen konsumiere ich grundsätzlich nicht – bin da gestern auch eher nur durch Zufall drüber gestolpert.

Tja, bei mir waren bei Klassenarbeiten programmierbare Taschenrechner verboten.

Beim allen Klassenarbeiten der 13. Klasse und beim Abi war sogar die Benutzung eigener Taschenrechner verboten.

Es wurden Taschenrechner von der Schule ausgegeben und nur die durften benutzt werden.

War etwas blöd, da man sich erst einmal mit der Bedienung des Taschenrechners vertraut machen musste, wenn man nicht privat den gleichen oder einen ähnlichen Taschenrechner hatte.

Und auch alle anderen Materialien wie Papier, Stifte, Lineal, etc. etc. wurde beim Abi von der Schule gestellt.

Man durfte keine persönlichen Gegenstände mit in den Raum nehmen, auch keine Jacken, Taschen, etc.

Solche Regeln sind oft direkte Folgen von vorherigen Betrugsversuchen…

Der lustigste Teil an dem trojanischen Pferd, dass Will Teague hier vor den Toren seiner Studenten abgestellt hat, ist eigentlich, dass der okkulte Prompt "Schreibe aus einer marxistischen Perspektive" lautet und die Schüler die Ergebnisse als "sounds smart" empfanden.

Das sagt schon viel darüber aus, wo hier das Problem ist und wie wir in diese Bildungsmisere gekommen sind. Es ist ja keine Strafe Gottes oder eine unverschuldete Naturkatastrophe, die passiert ist, sondern exakt das: Marxistische Rabulistik von Gleichheit hat Ideologen in Positionen gebracht, in denen sie dafür sorgen konnten, dass Menschen an Hochschule kommen, die besser auf einem Feld, im Handwerk oder in einer Fabrik gelandet wären. Und nun müssen diese Leute irgendwie in einem Wettbewerb bestehen, für den sie nicht das Rüstzeug mitbringen. Also betrügen sie. Surprised Pikachu face. Das ist ja Diebstahl an ihrem Leben und am Leben aller anderen, die mit so einem Quatsch umgehen müssen, aber so ist das halt, wenn Ideologie die Realität schlägt.

Nur: Das wird wieder ignoriert. Stattdessen kapriziert man auf den Teil, der eigentlich nicht besonders spannend ist: Die LLM, die diese Texte produzieren, sind halt Werkzeuge wie ein Hammer, eine Suchmaschine oder ein Taschenrechner. Wer sie benutzen kann, profitiert, wer nicht, der nicht. Sie zu verdammen ist wie eine elektrische Bohrmaschine zu verdammen, weil keiner mehr manuell Löcher bohren will. Den Esel schlagen, wenn man den Herren meint, aber den Herren nicht meinen darf.

Aber was soll die Lehre sein: LLM zu verbieten, weil einige Menschen zu blöde sind, ihre langfristigen Konsequenzen zu verstehen? Sie – wie ein bockiger Opa – nicht zu nutzen, weil andere zu dumm sind, sie richtig zu benutzen? Die Büchse der Pandora steht, wie viele andere Büchsen, offen und die Konsequenzen daraus will keiner ziehen, weil sie eben der vorherrschenden Ideologie widersprechen. Teague hat hier auch tatsächlich gar keinen Punkt gegen KI gemacht, sondern gegen das Bildungssystem und die Gesellschaft, deren Teil er selbst ist.

Fairerweise muss man sagen, dass der gelbe Zettel im Beispielbild umgangssprachlich mindestens zwei Interpretationen zulässt:

– Sorgen Sie dafür, dass Ihr Kind spätestens um 10 Uhr hier ankommt.

– Sorgen Sie dafür, dass Ihr Kind nicht vor 10 Uhr hier weggeht.

Aber ich weiss natürlich nicht, was in dem Test die konkrete Frage war.

Diese "Verblödung" hat bereits um 2000 – 2005 angefangen, nur das es um diesen Zeitraum rum nur die Wenigsten wahrgenommen und laut ausgesprochen haben. Und, wenn ja, dann wurden sie meist als "Nestbeschmutzer" und mit "Sie haben ja keine Ahnung, ich kann sogar meinen Namen tanzen" abgekanzelt wurden.

Außerdem für die kommende Diktatur ist blödes Volk doch viel leichter händelbar.

Ich entschuldige mich vorsorglich, falls sich jemand auf die Füße getreten fühlt!

| Da wächst die nächste Generation der Blender und nicht Wissenden heran, die

| die Gesellschaft die nächsten 30 Jahre tragen und weiter entwickeln soll.

Das tun die, mit Bravour, aus Bundestag/Bundesrat/Landtagen und sonstigen mehr oder weniger angeschlossenen Behörden und GONGOs.

Eine Schule kann befehlen: "Du darfst keine KI für Deine Schulaufgaben nutzen!". Falls ihr Teenager habt, könnt ihr sicherlich nachvollziehen: Ein kleiner Teil wird das vielleicht beherzigen, der größere Teil – nicht. Nun kann man versuchen, die schwarzen Schafe zu identifizieren und dann zu bestrafen (das versuchen bezieht sich auf beide mit "UND" verbundenen Satzbestandteile!). Wird das helfen, das Problem zu beseitigen? Wird es dazu führen, kein LLM mehr zu benutzen?

Sollte die Schule dann nicht eher eher Umgang und Risiken mit KI lehren und trainieren? Müssen sich dann nicht die Prüfungsbedingungen ändern? Hausarbeiten kann man offensichtlich vergessen, und "im Abi zeigt es sich dann" käme viel zu spät.

Sich der Realität entgegenzustellen, wird das gesellschaftliche(!) Problem auf jeden Fall nicht beseitigen.

Ohne den Beitrag, sondern nur die Überschrift, gelesen zu haben. JA!

Ich sehe es überall, jeden Tag.

Für so viele Bespiele, aus meiner Umgebung, reicht hier der Platz nicht.

Übrigens ist dieser Kommentar ohne Schreibhilfen erstellt worden.

Wie viele Fehler habe ich gemacht?

Die Blender sind längst in der Mehrheit. Und sie werden ihren Platz am Futtertrog nicht räumen wollen. Blender sorgen inzwischen schon seit Jahrzehnten dafür, dass andere Blender nach oben kommen – und niemand, der sie stört. So etwas wie diese dussligen LLM sind für solche Leute ein wahrgewordener Traum – und sie sind einfach zu borniert, um zu begreifen, wohin das führt.

100% Zustimmung, leider.