AI bzw. der Gebrauch von Sprachmodellen (LLMs) wie ChatGPT ist ja Dauerthema – angeblich so wichtig wie geschnitten Brot. Insidern ist klar, dass diese Technologie die größte Gefahr für Daten-und Unternehmenssicherheit seit Einführung des Internet ist. Mir sind zwei Informationssplitter in diesem Kontext untergekommen. ChatGPT von OpenAI weist sieben als HackedGPT bezeichnete Schwachstellen und Angriffstechniken in der Version 40 auf, die auch in Version 50 nachgewiesen werden können. Und 65% aller großen Sprachmodelle leaken Geheimnisse (Tokens etc.).

AI bzw. der Gebrauch von Sprachmodellen (LLMs) wie ChatGPT ist ja Dauerthema – angeblich so wichtig wie geschnitten Brot. Insidern ist klar, dass diese Technologie die größte Gefahr für Daten-und Unternehmenssicherheit seit Einführung des Internet ist. Mir sind zwei Informationssplitter in diesem Kontext untergekommen. ChatGPT von OpenAI weist sieben als HackedGPT bezeichnete Schwachstellen und Angriffstechniken in der Version 40 auf, die auch in Version 50 nachgewiesen werden können. Und 65% aller großen Sprachmodelle leaken Geheimnisse (Tokens etc.).

LLMs der großen AI-Anbieter leaken API-Keys

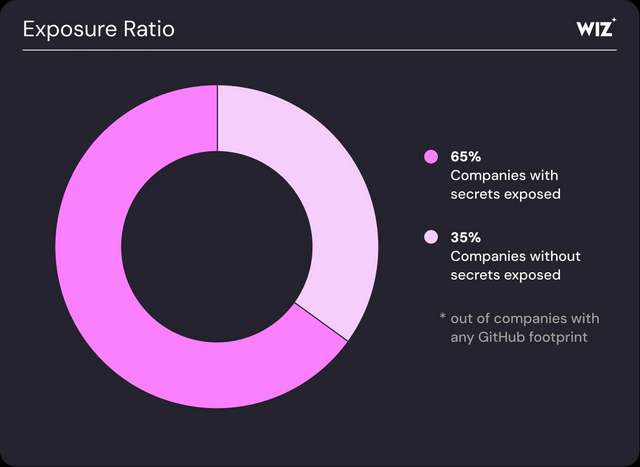

Im Rattenrennen um die vermeintlich vordern Plätze versuchen sich die große AI-Anbieter in Punkto Schnelligkeit gegenseitig zu übertrumpfen. Dabei gerät die Sicherheit unter die Räder. Cloud-Sicherheitsanbieter Wiz hat sich die Sprachmodelle von 50 großen AI-Anbietern im Hinblick auf Sicherheit angesehen. Die Details dieser Untersuchung wurden im Blog-Post Exposure Report: 65% of Leading AI Companies Found with Verified Secret Leaks veröffentlicht (via).

AI-Lösungen leaken Geheimnisse; Quelle: Wiz

Als Ergebnis wurde festgestellt, dass 65 % der Anbieter verifizierte Geheimnisse auf GitHub preisgegeben haben. Dabei handelt es sich um API-Schlüssel, Tokens und sensible Anmeldedaten, die oft tief in gelöschten Forks, Gists und Entwickler-Repositories vergraben sind. Diese Geheimnisse werden von den meisten Sicherheitsscannern der AI-Anbieter nie erfasst und geraten dann auf GitHub. Einige dieser Lecks hätten Organisationsstrukturen, Trainingsdaten oder sogar private Modelle offenlegen können, schreibt Wiz.

Das Leaken von Geheimnissen in seinen Daten ist seit Jahren ein Problem von Sprachmodellen (LLMs), was die Branche nicht in den Griff bekommt. Der Anbieter gibt AI-Entwicklerteams den Ratschlag, dass Geschwindigkeit und Sicherheit Hand in Hand gehen müssen.

HackedGPT: Sieben kritische ChatGPT Sicherheitslücken

Schaut man sich den Platzhirsch ChatGPT an, sieht es nicht besser aus. Sicherheitsforscher von Tenable habe in dieser AI-Software gleich sieben kritische Schwachstellen aufgedeckt. Diese ermöglichen die Exfiltration von Daten, die Aufhebung von Sicherheitsmaßnahmen und eine anhaltende Kompromittierungen innerhalb des ChatGPT-Sprachmodells.

Sicherheitsforscher des Exposure Management-Anbieters Tenable haben ChatGPT-4o von OpenAI diesbezüglich getestet. Von den sieben Schwachstellen und Angriffstechniken konnten einige später auch in ChatGPT-5 nachgewiesen werden. Diese kollektiv als HackedGPT bezeichneten Schwachstellen setzen Benutzer Datenschutzrisiken aus, indem sie integrierte Sicherheitsmechanismen umgehen.

Obwohl OpenAI inzwischen einige der identifizierten Probleme behoben hat, waren andere zum Zeitpunkt der Veröffentlichung noch ungelöst, sodass bestimmte Kompromittierungspfade weiterhin bestehen. Im Falle einer Ausnutzung könnten sie es Angreifern ermöglichen, unbemerkt persönliche Daten, einschließlich gespeicherter Chats und Erinnerungen, zu stehlen.

Angriffe über Indirect Prompt Injection

Die Schwachstellen offenbaren eine neue Art von KI-Angriffen schreibt Tenable und bezeichnet das Ganze als "Indirect Prompt Injection". Bei dieser Angriffsmethode werden versteckte Anweisungen in externen Websites oder Kommentaren eingebettet. Angreifer verbergen die schädlichen Befehle in legitim erscheinenden Online-Inhalten wie Blog-Kommentaren oder öffentlichen Posts.

Diese sollen das Sprachmodell (LLM) dazu veranlassen, unbefugte Aktionen auszuführen. Beim Durchsuchen dieser Inhalte befolgt ChatGPT unwissentlich diese versteckten Anweisungen. Auf den Punkt gebracht: Es reicht, wenn ChatGPT eine kompromittierte Seite liest, auf der diese Anweisungen versteckt sind. Der ChatGPT-Benutzer konnt dies weder erkennen noch beeinflussen. Betroffen sind die Web-Browsing- und Speicherfunktionen von ChatGPT, die Live-Internetdaten verarbeiten und Benutzerinformationen speichern und somit Möglichkeiten für Manipulationen und Datenlecks eröffnen.

Zwei Arten von Angriffen

Tenable Research hat gezeigt, dass diese Angriffe über Indirect Prompt Injection unbemerkt auf zwei Arten erfolgen können:

- "0-Klick"-Angriffe, bei denen allein das Stellen einer Frage an ChatGPT die Kompromittierung auslöst. Nutzer müssen weder klicken noch irgendetwas Besonderes tun, um kompromittiert zu werden. Wenn ChatGPT im Internet nach Antworten sucht, kann es auf eine Seite mit verstecktem Schadcode stoßen. Einfach nur eine Frage zu stellen, könnte dazu führen, dass das Modell solche Anweisungen befolgt und private Daten preisgibt – was Forscher als "Single-Prompt-Kompromittierung" bezeichnen

- "1-Klick"-Angriffe, bei denen das Anklicken eines bösartigen Links versteckte Befehle aktiviert. Versteckte Befehle, die in scheinbar harmlosen Links eingebettet sind, wie beispielsweise https://chatgpt.com/?q={Prompt}, können dazu führen, dass ChatGPT bösartige Aktionen ausführt, ohne sich dessen bewusst zu sein. Ein Klick genügt, damit ein Angreifer die Kontrolle über einen Chat übernehmen kann.

Die obigen Angriffstechniken zeigen bereits eindringlich, wie riskant die Verwendung von Sprachmodelle wie ChatGPT ist, die ihre Informationen aus öffentlich verfügbaren, also unkontrollierbaren Inhalten beziehen.

Umgehen von Sicherheitsmechanismen

Ein Problem ist auch das Umgehen von Sicherheitsmechnismen. Normalerweise überprüft ChatGPT Links und blockiert unsichere Websites. Angreifer umgehen dies, indem sie vertrauenswürdige Wrapper-URLs verwenden (z. B. bing.com/ck/a?… von Bing), die das tatsächliche Ziel verbergen. ChatGPT vertraut dem Wrapper, zeigt den scheinbar sicheren Link an und kann zu einer bösartigen Website weitergeleitet werden.

Persistent Memory Injection

Die Speicherfunktion von ChatGPT zeichnet vergangene Interaktionen auf. Noch besorgniserregender ist eine Angriffstechnik, die als "Persistent Memory Injection" bezeichnet wird, und auf dem Mechanismus vergangener Interaktionen aufsetzt. Bei dieser Angriffstechnik werden schädliche Befehle im Langzeitspeicher von ChatGPT gespeichert. Die Befehle bleiben auch dann noch aktiv, wenn der Nutzer die App schließt.

Auf diese Weise können Angreifer dauerhafte Bedrohungen in die Benutzerschnittstelle von ChatGPT einschleusen, die private Informationen in künftigen Sitzungen offenlegen können. Die Befehle bleiben persistent im Langzeitspeicher, bis sie durch Löschen dieses Speichers entfernt werden. Zusammen genommen zeigen diese Schwachstellen, wie Angreifer die Sicherheitsvorkehrungen von OpenAI umgehen und auf die privaten Verlaufsdaten der Nutzer zugreifen könnten.

Conversation Injection

ChatGPT nutzt zwei Systeme – SearchGPT für die Suche und ChatGPT für Konversationen. Angreifer können sich SearchGPT zunutze machen, um versteckte Anweisungen einzufügen, die ChatGPT später im Rahmen der Konversation ausliest. Tatsächlich führt die KI letztendlich eine „Prompt Injection" bei sich selbst durch, indem sie Befehle ausführt, die der Benutzer nie geschrieben hat.

Verbergen bösartiger Inhalte

Ein Programmierfehler in der Formatierung ermöglicht es Angreifern, schädliche Anweisungen in Code oder Markdown-Text zu verstecken. Dem Nutzer wird eine saubere Nachricht angezeigt, aber ChatGPT liest dennoch den versteckten Inhalt und führt ihn aus.

Die Implikationen von HackedGPT

Viele Hundert Millionen Menschen nutzen ChatGPT täglich für geschäftliche Zwecke, Recherchen und persönliche Kommunikation. Eine Ausnutzung dieser Schwachstellen könnte zu Folgendem führen:

- Einfügen versteckter Befehle in Konversationen oder Langzeitspeicher

- Abgreifen sensible Daten aus Chat-Verläufen oder verbundenen Diensten wie Google Drive oder Gmail

- Ausspähen von Informationen über Browser- und Web-Integrationen

- Manipulieren von Antworten, um Fehlinformationen zu verbreiten oder Nutzer zu beeinflussen

"HackedGPT deckt eine grundlegende Unzulänglichkeit in der Art und Weise auf, wie große Sprachmodelle beurteilen, welchen Informationen sie vertrauen können", erklärte Moshe Bernstein, Senior Research Engineer bei Tenable. Einzeln betrachtet scheinen diese Sicherheitslücken geringfügig zu sein – in ihrer Gesamtheit bilden sie laut Tenable jedoch eine komplette Angriffskette: Diese reicht von der Einschleusung der Befehle und Umgehung der Sicherheitsmechanismen bis hin zu Datendiebstahl und Persistenz.

Dies verdeutlicht, dass KI-Systeme nicht nur potenzielle Angriffsziele darstellen, sondern dass Unbefugte diese auch zu Angriffstools umfunktionieren können, die unbemerkt Informationen aus alltäglichen Chats oder beim Surfen abgreifen.

Tenable Research hat seine Untersuchung vorab im Rahmen einer verantwortungsvollen Offenlegung an OpenAI gemeldet und das Ganz im Detail in diesem Blog-Beitrag veröffentlicht. Laut Tenable wurden von OpenAI zwar einige der identifizierten Schwachstellen behoben. Aber verschiedene Schwachstellen sind weiterhin in ChatGPT-5 aktiv oder wurden zum Zeitpunkt der Veröffentlichung noch nicht behoben. Man sollte also davon ausgehen, dass bestimmte Kompromittierungspfade in ChatGPT offen bleiben.

Empfehlungen für Sicherheitsteams

Tenable empfiehlt Anbietern von KI-Lösungen, ihre Abwehrmaßnahmen gegen Prompt Injection zu verstärken, indem sie sicherstellen, dass Sicherheitsmechanismen wie url_safe wie vorgesehen funktionieren, und indem sie Browsing-, Such- und Speicherfunktionen isolieren, um kontextübergreifende Angriffe zu verhindern. Für Sicherheitsexperten hält Tenable Folgendes an Ratschlägen bereit:

- Behandeln Sie KI-Tools als aktive Angriffsflächen und nicht als passive Assistenten.

- Überprüfen und überwachen Sie KI-Integrationen auf mögliche Manipulationen oder Datenlecks.

- Untersuchen Sie ungewöhnliche Anfragen oder Ausgaben, die auf Prompt Injection hindeuten könnten.

- Testen und verstärken Sie die Abwehrmaßnahmen gegen Injektions- und Exfiltrationspfade.

- Führen Sie Kontrollmechanismen für Governance und Datenklassifizierung im Zusammenhang mit KI-Nutzung ein.

"Bei dieser Untersuchung geht es nicht nur um die Aufdeckung von Schwachstellen, sondern darum, die Art und Weise der Absicherung von KI zu verändern", sagt Moshe Bernstein, Senior Research Engineer bei Tenable. "Sowohl Einzelpersonen als auch Unternehmen müssen davon ausgehen, dass KI-Tools manipuliert werden können, und entsprechende Kontrollmechanismen entwickeln. Das bedeutet Governance, Datensicherheit und ständiges Testen, um sicherzustellen, dass diese Systeme für uns arbeiten und nicht gegen uns."

Ich sage es mal so: Ein normaler Nutzer kann dies doch gar nicht leisten – und die normalen Mitarbeiter in den IT-Abteilungen werden da ebenfalls weder die Zeit noch die Expertise haben, das alles abzusichern. Mir kommt das Ganze wie "ein Ritt auf der Rasierklinge" vor, wo die Leute sich auch noch freuen, vermeintlich modern zu sein. Spätestens bei ersten größeren Vorfällen kommt das böse Erwachen und der Katzenjammer "konnte ja keiner ahnen". Vom Risiko, dass die von der AI gelieferten Informationen durch Halluzinationen oder bewusste Verfälschungen (Stichwort Sabotage) wertlos bzw. falsch sind, will ich erst gar nicht sprechen – das ist doch alles sattsam bekannt.

MVP: 2013 – 2016

MVP: 2013 – 2016

Ich sehe das erst als die Spitze des Eisbergs.

Wer weiß, was sich noch unter der Oberfläche so verbirgt.

Und wer weiß, ob diese Schwachstellen tatsächlich behoben wurden, oder ob die Ergebnisse nur woanders hin umgeleitet werden, um so an fremde Daten zu gelangen.

Und Ja, ein normaler Benutzer kann das, was Tenable empfiehlt, gar nicht leisten. Und wohl auch keine IT-Abteilung.

Und selbst wenn: Dann würde es erhebliche Mehrarbeit bedeuten und die angeblichen Erleichtungen durch die KI ins Gegenteil verkehren.

Bzw. das ist ja jetzt schon der Fall, denn man muss eigentlich jedes Ergebnis, das eine KI einem liefert, auf Plausibilität und Richtigkeit prüfen.

Übrigens:

Der Artikeltext sollte noch einmal überarbeitet werden.

Da sind doch ein paar Rechtschreibfehler (z.B. fordern Plätze, soll wohl vorderen Plätze heißen oder Benutzerschnittstellt, soll wohl Benutzerschnittstelle heißen, etc.) drin.

Betr. "… Spitze des Eisbergs. Wer weiß, was sich noch unter der Oberfläche so verbirgt.":

Kein Grund zur Aufregung, s. https://www.youtube.com/watch?v=uOyAi0hKy4Q

Witze sollte man eigentlich nicht richtigstellen, mir ist aber der falsche URL in die Hände geraten. Der richtige betr. Eisberg lautet: https://www.youtube.com/watch?v=EPJCe6UChsU.

+ Fehlerhafte Software, mangelnde Autorisierung, abfliessende Geheimnisse:

Alles Dinge, mit denen sich EDV schon seit Jahrzehnten herumschlägt. Also nichts Neues unter der Sonne.

+ Betr. "Insidern ist klar, dass diese Technologie die größte Gefahr für Daten-und Unternehmenssicherheit seit Einführung des Internet ist.":

Wohl kaum; die grösste Gefahr seit Einführung des Internets ist vielmehr das Internet (Zwinkersmiley) resp. dessen soziale Kosten (Bsp. (1)). Da mal drüber nachdenken.

–

(1) https://www.spiegel.de/panorama/justiz/mobbing-und-cybermobbing-millionen-deutsche-laut-studie-betroffen-a-afd67abc-25c9-4683-9151-75c4fcba49cf

Ja, das ist das Copium, wenn man die Augen vor dem LLM Desaster verschliessen möchte…

Wir nutzen auf der Arbeit und privat Comet/Perplexity.

Witzig, sowas als "Anonym" zu posten. :-)

Die Mitarbeiter in der IT wissen oft gar nicht, dass überhaupt jemand im Unternehmen LLM benutzt, damit fängt es doch schon an. Und wenn gesagt würde "dürft Ihr nicht", würden sie es trotzdem tun. Und Vorgesetzte wollen ja ohnehin "modern" sein und denken immer noch, es würde Effizienz bringen. Es muss also leider erst knallen und es wird knallen.

wo ist das neue Problem im ersten Teil? "API-Schlüssel, Tokens und sensible Anmeldedaten, die oft tief in gelöschten Forks, Gists und Entwickler-Repositories vergraben sind" sind doch bereits öffentlich – oder gewesen. Und damit weiter als öffentlich anzusehen.

Wer ein Token in einem öffentlichen Forum gepostet hat sollte sich ohnehin nicht darauf verlassen, dass er das gelöscht hat, sondern zusätzlich das Token ändern – es könnte zwischen Post und Löschung angeschaut worden/abgeflossen sein (zusätzlich sind gelöscht und "als gelöscht markiert" bekanntermaßen nicht identisch). Ähnlich in den anderen Fällen.

Oder habe ich das grundlegend falsch verstanden?

Vergiss nicht die "Programmierer" die irgendwelche Dateien inklusive Tokens usw. bei ChatGPT o.ä. hochladen und fragen, wo da ein Fehler ist oder wie man da was einbauen kann oder in deren lokaler oder eigentlich nicht öffentlicher Code Basis inklusive Tokens in ihrem Cloud Drive irgendein Copilot o.ä. herumschnüffelt…

Was für Token, Was für API

Was wird da geleakt

Warum hat eine KI überhaupt Token und API

Was hat Github damit zu tun

Kapiere gar nichts