AI-Suchmaschinen drücken dem freien Web gerade die Luft ab und versetzen diesem den Todesstoß. Diese Beobachtung wurde bereits vor Monaten von Publishern beschrieben. Google hielt dem im Mai 2025 noch entgegen, dass die AI den Publishern sogar hochwertigen Traffic beschert. Ein Gerichtsdokument für das Verfahren zur Zerschlagung von Google belegt aber, dass man intern gänzlich anders argumentiert und das "freie Web" im Sterben sieht.

AI-Suchmaschinen drücken dem freien Web gerade die Luft ab und versetzen diesem den Todesstoß. Diese Beobachtung wurde bereits vor Monaten von Publishern beschrieben. Google hielt dem im Mai 2025 noch entgegen, dass die AI den Publishern sogar hochwertigen Traffic beschert. Ein Gerichtsdokument für das Verfahren zur Zerschlagung von Google belegt aber, dass man intern gänzlich anders argumentiert und das "freie Web" im Sterben sieht.

These: Das freie Web wird sterben

Spätestens seit Microsoft und Google damit begonnen haben, bei der Suche einen Excerpt der Treffer per AI an den Anfang der Ergebnisliste zu stellen, musste jedem Publisher klar sein, dass das Web mit seinen Webseiteninhalten, wie wir es heute kennen, nicht überlebt.

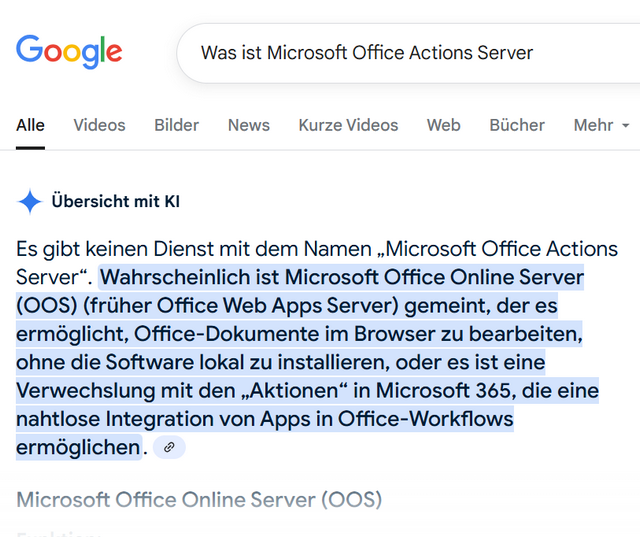

Die Ergebnisse – zumindest bei Google – sind zwar grottenschlecht, wie ich im Beitrag Finger weg: Die Google AI-Suchergebnisse sind eine Katastrophe! angemerkt habe. Aber die Masse der Internet-Surfer merkt das nicht, nimmt die AI-Zusammenfassungen für bare Münze und spart sich den Besuch der betreffenden Webseiten. Auf die sich ergebenden negativen Folgen, wie 10fach höherer Energieverbrauch einer AI-Anfragen im Vergleich zu einer normalen Suche möchte ich hier nicht detailliert eingehen.

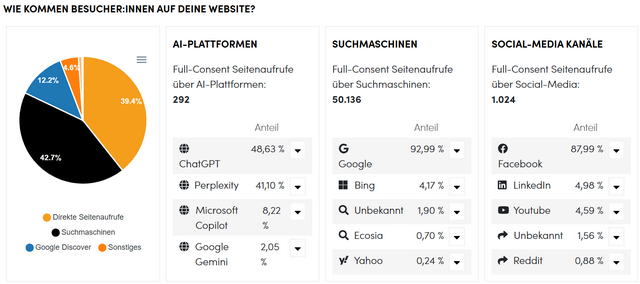

Der springende Punkt ist der Umstand, dass die AI-Zusammenfassungen den Traffic auf den Quellseiten reduzieren. In obigem Beitrag hatte ich die obige Übersicht gezeigt, die die Besucher, die über 7 Tage aus diversen Quellen indirekt bei borncity.com landen, angibt. Die AI-Plattformen haben mit 292 Treffern im Vergleich zu über 50.000 Weiterleitungen von Suchmaschinen, kaum Besucher gebracht.

Frank Scholl: Google KI-Suche lässt Besucherzahlen einbrechen

Bereits im April 2024 hat Frank Scholl, der Betreiber von administrator.de, den Beitrag Webseiten im Existenzkampf: Googles KI-Suche lässt Besucherzahlen einbrechen veröffentlicht. Es ging darum, dass sich gerade einige Dinge fundamental im freien Web durch zwei Entscheidungen Googles ändern.

- Die Nachhaltigkeit von Beiträgen steht nicht mehr im Fokus, neue Beiträge werden höher gerankt als ältere Beiträge.

- Google versucht nun, mit Hilfe von KI dem Nutzer als ersten Treffer eine Zusammenfassung von Inhalten bestehender Webseiten als Antwort zu präsentieren.

Bedeutet, dass Google keinen Wert mehr auf qualitativ wertige Beiträge legt, sondern möglichst nur die nächste News in seinen Suchergebnissen präsentiert. Und durch die KI-Zusammenfassung gehen den Inhaltserstellern die Besucher, die bisher über die Google Suche kamen, verloren.

Die Aussage von Frank war: "… Google setzt damit eine gefährliche Abwärtsspirale für beide Seiten in Gang. Seitenbetreiber bekommen weniger Seitenaufrufe und Google bekommt immer weniger Inhalte von den Seiten, wenn diese in Zukunft keine oder weniger Nutzer mehr haben." Frank schrieb, dass selbst bei großen Seiten der Anteil der Besucher, die von der Google-Suche kommt, in der Regel bei 70 bis 80 Prozent liege. Sieht aktuell bei meinem Blog zwar noch anders aus, aber der Trend ist da.

Dr. Windows: Todesursache KI

Am 18. Juli hat Martin Geuß auf Dr. Windows den Artikel Todesursache KI: Warum Dr. Windows stirbt und Linux-Fans deshalb traurig sein sollten publiziert, in dem er ebenfalls auf die Entwicklung eingeht. Und zum 21. Juli 2025 hat Kevin Kozuszek dann bei Dr. Windows den Beitrag In eigener Sache: Todesursache KI – eine genauere Einordnung aufgegriffen und eingeordnet.

Die Botschaft beider Artikel war: Das Internet, wie wir es heute kennen und lieben, funktioniert nicht mehr. Durch die KI-Zusammenfassungen schnürt Google dem Web die Luft ab. Das gilt aber auch für die anderen AI-Angebote wie ChatGPT, Bing, Antrophic etc. Das Geschäftsmodell, Inhalte im Web bereitzustellen und durch Werbung zu finanzieren, ist durch die KI-Zusammenfassungen entfallen.

Im Artikel hieß es aber auch, dass Google keine andere Wahl habe, als diesen Weg zu gehen, selbst wenn sie sich den Geschäftszweig "Werbung auf Webseiten zu schalten", kaputt machen. Es wird, so die Botschaft der beiden Artikel, zwar kein sofortiges Abschalten von Dr. Windows geben. Aber die mittel- bis langfristigen Folgen sind kaum abzuschätzen – das Internet wird sich rasend verändern, und mutmaßlich nicht zum Guten.

Ich selbst habe die obigen Artikel seinerzeit zeitnah gelesen, mich hier aus diversen Gründen nicht geäußert. Einmal wollte ich als potentiell Betroffener nicht in die Diskussion eingreifen. Weiterhin sehe ich für mich persönlich das Ganze entspannter. Mein Projekt borncity.com ist zwar dieses Jahr mit dem IT-Blog 18 Jahre alt geworden. Aber ich befinde mich im Auslaufmodus und werde keine weiteren 18 Jahre mehr bloggen, sondern nur noch solange es Spaß und Sinn macht. Der Trigger für den Beitrag kommt aus einer anderen Ecke: Es gibt nämlich zwei sich widersprechende Google-Aussagen, die ich nachfolgend aufgreifen möchte.

Google: Web-Publishing ist nicht tot

Im Mai 2025 gab es ein Interview mit Sundar Pichai, dem CEO von Google, dass von Nilay Patel, The Verge, geführt wurde. Die Seite Search Engine hat die Kernaussagen im Beitrag Google's Sundar Pichai Doesn't Think Web Publishing Is Dead zusammen gefasst.

Nilay wies darauf darauf hin, dass sich die Änderungen bei den KI-Übersichten und dem KI-Modus in der Google-Suche sehr negativ auf Publisher auswirken. Sundar Pichai wollte die Meinung, dass das Web-Publishing tot sei, nicht stehen lassen und argumentierte, dass er "in den letzten zwei Jahren 45 % mehr Inhalte im Web gesehen habe als zuvor" und dass dies nicht auf KI-Tools und genierte Inhalte zurückzuführen sei.

Die Aussage von Pichai war: "In fünf Jahren werden wir [Google] viel Traffic ins Internet schicken." – aber er wies auch darauf hin, dass andere KI-Unternehmen sich nicht um Publisher kümmern würden.

Google bestätigt vor Gericht den Wandel des Web

Die Seite Search Engine hat zum 8. September 2025 den Artikel New Google Court Doc: Open Web Is In Rapid Decline publiziert. Google muss sich in einem Verfahren, in dem das US-Justizministerium die Zerschlagung des Unternehmens vor Gericht beantragt, verteidigen. Ich hatte die Tage im Beitrag USA gegen Google: Android und Chrome müssen nicht verkauft werden auf das Verfahren und erste Entscheidungen des zuständigen Gerichts hingewiesen.

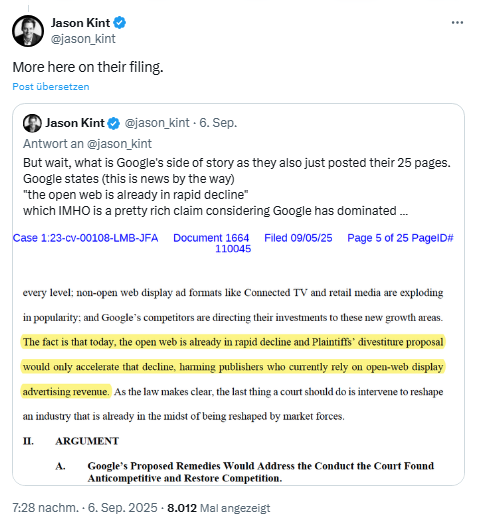

In einem zum 5. September 2025 eingereichten Gerichtsdokument (PDF), schreiben die Anwälte von Google: "Tatsache ist, dass das offene Internet bereits heute rapide an Bedeutung verliert." Jason Kint ist das aufgefallen und er hat es in nachfolgendem Tweet aufgegriffen.

Die Original-Aussage der Anwälte, die gegen eine Zerschlagung argumentieren, lautet in Deutsch übersetzt:

Tatsache ist, dass das offene Internet bereits heute rapide an Bedeutung verliert und der Veräußerungsvorschlag der Kläger diesen Niedergang nur noch beschleunigen würde, was den Verlagen schaden würde, die derzeit auf Werbeeinnahmen aus Display-Werbung im offenen Internet angewiesen sind.

Es wird bestätigt, dass das offene Internet rapide an Bedeutung verliert, so dass eine Zerschlagung von Google den Niedergang noch beschleunigt. Klingt ein wenig wie "rettet, was zu retten ist, und wir sind die Guten". Aber ich sehe es auch so, Google sitzt, was seine Werbung betrifft, auf einem Ast, den es mit seinen Wettbewerbern gerade absägt.

Hier im Blog bin ich dabei, Google gerade weitgehend als Werbenetzwerk rauszuwerfen. Der Testbetrieb läuft bereits im Japan-Blog auf borncity.eu und ich werde voraussichtlich bis zum 1. Oktober 2025 weitere Blogs umstellen – der IT-Blog hier folgt zum genannten Stichtag. Und dann werde ich sehen, wie lange es noch sinnvoll und möglich ist und Spaß macht. Aber die Party geht langsam zu Ende.

MVP: 2013 – 2016

MVP: 2013 – 2016

Ich lese leider keine Zeitung, so weiß ich nicht, was die Masse der Menschen hier im Land Denkt noch, was ihr hier so vorgesetzt wird zu Glauben.

Nur soviel, dass sich die KI mittlerweile selbst abschreibt wie https://www.theregister.com/2025/09/07/googles_ai_cites_written_by_ai/ Schreibt, das Ende des Freien Internets ist also nahe.

The Register Zitat: Das Unternehmen, das die AIO-Zitate durch sein AI Detection Lite 1.0.1-Modell durchführte, fand heraus, dass 10,4 Prozent von ihnen wahrscheinlich von einem LLM generiert wurden. Dies bedeutet, dass eine KI auf die Produktion aus einem anderen schöpft, was zu einer Echokammer von recycelten Ideen und Vorurteilen beitragen könnte.

Die klassische Google-Suche wird schon seit einiger Zeit immer schlechter, als ob man die Leute zu KI-Suchen prügeln wollte. Ich suche öfter mal nach (aus heutiger Sicht) relativ seltenen Themen. Google lässt dann von sich aus Suchbegriffe weg und liefert in den ersten 30 Ergebnissen überwiegend nur Müll, der mit dem Thema fast nichts zu tun hat, die restlichen Ergebnisse schau ich mir dann gar nicht mehr an. Oft muss man jeden einzelnen Begriff in Anführungszeichen setzen. Was soll das? Ich würde es ja noch verstehen, wenn es sich um offensichtliche Tippfehler handeln würde, die auf diese Weise korrigiert würden. Aber oft hat man den Eindruck, daß Google eine bestimmte Vorstellung davon hat, wonach der Kunde zu suchen hat.

Um hier mal einen anderen Blickwinkel einzunehmen: Das wahre Problem ist nicht, dass die Google Suche immer schlechter wird oder KI falsche Ergebnisse liefert, sondern dass der Buchmarkt am Boden liegt. Kauft mal (mehr) Bücher und lest und bildet euch. Dann braucht ihr euch auch nicht mehr über Google, Copilot und Konsorten beschweren.

Was meinst du den konkret mit "Büchern"?

Wenn ich nach Möglichkeiten Suche die Stützen eines Carports zu verankern, dann kaufe ich mir i.d.R. kein Buch in der Hoffnung, dass da irgendwas steht. Das ist doch total realitätsfern.

Wenn das Thema größer ist oder man sich genauer informieren möchte, da kann man ggf. über Bücher nachdenken. ABER Bücher haben ebenfalls Probleme wie Google und aus meiner Sicht noch gravierender. Das ist aus meiner Sicht auch ein Grund warum der Buchmarkt am Boden liegt.

-Bücher Online kaufen fällt schon mal weg, weil es praktisch nicht Möglich ist vorab wirklich zu evaluieren, ob das Buch hilfreich ist oder nicht. Man müsste schon in den Buchladen fahren, sich dort ein Buch ansehen kaufen und hoffen, dass der erste Eindruck sich bestätigt.

-Viele Ideen/Sichtweisen aus Büchern sind schon in diversen Blogs/Webseiten/Videos aufgegriffen, oft deutlich ausführlicher und besser dargestellt. Ein wesentlicher Vorteil von Büchern fällt damit eigentlich komplett.

-Wirklich Struktur haben viele Bücher auch nicht. Es ist halt die Frage, ob die Leute die Bücher schreiben und die Verlage hier wirklich bessere Arbeit machen als irgendwelche Blogger. Aktuell ist auch so viel Schrott auf dem Markt, dass man erst nach mehreren Fehlkäufen ein Buch findet was wirklich mal ETWAS Mehrwert bietet. Wie gesagt, selbst dieser Mehrwert ist dann fraglich. Weil das Buch "statisch" ist und halt nur die Infos hat die da drinnen stehen. Um eine neue "Suchanfrage" zu starten müsste man sich ein neues Buch kaufen.

Die Qualität von 80% der auf dem Markt befindlichen "Fachbücher" ist absolut miserabel. Da bedient man sich dann lieber erstmal den ggf. auch illegalen online Libraries, um die Qualität und Inhalt zu checken. Das zeigt mal wieder, daß dies keine Piraterie ist, sondern den Absatz qualitativ hochwertiger Fachliteratur beflügeln kann.

Das Internet kriselt, weil Inhalte durch die nachlassende Qualität der Suchmaschinen und deren falsche Priorisierung (Mobile First, auch am PC) immer schlechter zugänglich sind. Wer will sich denn noch die Arbeit machen, wenn letztlich doch keiner mehr vorbei kommt?

Der Aufwand der Erstellung von Inhalten steigt. Früher war eine Webseite ein einfach mal eben hochgeladenes HTML. Hochladen und liegen lassen hat genügt. Heute muss man da schon mehr für tun.

Bücher sind Okay, aber ehrlich gesagt, die letzten beiden Bücher, die ich gekauft habe, waren über IBM und Pascal und haben nicht mal 2,20 Euro auf dem Flohmarkt gekostet.

Aber bevor ich mir ein neues Buch kaufe, kaufe ich mir erst eine neue Brille, das ist das leidige Problem, wenn man älter wird und wahrscheinlich auch damit zusammen hängt, dass ich die letzten 25 Jahre vor irgendwelchen Monitoren gesessen habe, es strengt an und nervt.

Im Übrigen haben Autoren und Hersteller ein großes Problem mit ihrem Produkt, es ist nicht nachhaltig und verbraucht mit der Zeit Platz im Regal.

Vor vielen Jahre ist mir das Projekt Deutsche Digitale Bibliothek in die Hände gefallen, alle Schiller Werke auf einer CD mit Kompakt suche. Das, was bei meiner 89 Jährigen Mutter ungefähr 2 Meter im Regal verschwendet und ich mich mittlerweile frage, was passiert damit nach ihrem ableben, wer wird sich das ins Regal stellen oder landet das einfach im Altpapier.

+ Betr. "Wenn ich nach Möglichkeiten Suche die Stützen eines Carports zu verankern, dann kaufe ich mir i.d.R. kein Buch in der Hoffnung, dass da irgendwas steht. Das ist doch total realitätsfern.":

– Ich weiss was Du meinst und grundsätzlich hast Du Recht. Es gibt durchaus Themen (viele sogar), für die keine Verlagspublikationen exisitieren (u. a. auch weil vergriffen). Das variiert sicher von Haushalt zu Haushalt, aber im Grundsatz halte ich daran fest, dass verlegerisch verantwortete Inhalte in Form und Inhalt die weitaus akkurateren und erschöpfenderen Quellen sind.

– Ja, Du hast recht. Die von Verlagen und Buchhandlungen unter 'Blick ins Buch' gebotenen Leseproben/Vorschauen müssten in Zahl und Umfang ausgebaut werden. Was nicht ist kann noch werden und muss vor allem von Lesern/Käufern verlangt werden. Und: Leser müssen auch grössere und bessere öffentliche Bibliotheken fordern! Was dort so im Bereich Fachbuch/Sachbuch rumsteht bzw. fehlt ist unter aller Kanone. Dort bestimmen die falschen Leute was beschafft wird. Alles wird der Unterhaltung geopfert, ein umfassendes Bildungsziel wird in den Beständen nicht sichtbar. S. a. die Rede (1) von Perthes-Preisträger Dennis Scheck, wenngleich er auf den Bereich Buchhandel und Belletristk fokussiert. Im Kern lässt sich seine Kritik m. E. aber auf die gesamte Literaturvermittlung/-versorgung extrapolieren: Zuviel Schund, zu wenig Relevantes an Publikationen.

+ Betr. "Man müsste schon in den Buchladen fahren, sich dort ein Buch ansehen kaufen und hoffen, dass der erste Eindruck sich bestätigt.":

Das vergiss mal; den Buchhandlungen resp. dem Personal fehlen jegliche Fähigkeiten zur Literaturermittlung und -beschaffung. Man fragt sich, was dort in den Berufsschulen überhaupt noch gelehrt wird. Wenn Du nicht schon mit einer ISBN kommst – was bedeutet, dass Du bereits die Literaturermittlung geleistet hast! – stehst Du in diesen Klitschen auf verlorenem Posten. Auch Universitätsbuchhandlungen sind kaum besser.

–

(1) https://www.boersenblatt.net/news/boersenverein/drachenscheisse-bleibt-drachenscheisse-377153

Ich habe eine große Auswahl an Büchern und greife darauf regelmäßig zurück. Obwohl die Bücker 2 Regale füllen und meine Interessen größtenteils abdecken, benötige ich dennoch das Internet. Gerade, wenn es um aktuelles Wissen geht. Denn bevor etwas neues in einem Buch erscheint, ziehen so einige Jahre ins Land. Neu erschienene Bücher kosten dann auch erstmal extra, weil die halt neu sind.

Bücher, sind das nicht die Dinger, die heute als KI-Massenware Amazon und Co überschwemmen?

Solche, die miserabel übersetzt werden? Silicon != Silicone

Oder meinst du historische Bücher, die noch echten Inhalt haben?

*SCNR*

Hört sich nach 'zwei Bücher reichen' (Stammbuch, Sparbuch) an. Wer sich bemüht, findet auch die guten Verlage und passenden Titel.

Das Problem ist, das Suchmaschinen wie google, bing, etc. etc. ihre Suchergebnisse filtern. Und diese Filterung ist auch noch landesspezifisch.

Bei Zugriffen aus Deutschland werden z.B. alle Ergebnisse herausgefiltert, die in Deutschland als FSK18 eingestuft sind.

D.H., je nachdem, aus welchem Land man auf google zugreift, bekommt man andere Ergebnisse.

Und gefiltert werden auch Ergebnisse, die nicht den Moralvorstellungen der Suchmaschinenbetreiber entsprechen.

Und dann kann man ja bei den Suchmaschinen auch noch beantragen, das die Ergebnisse von eigenen Seiten herausgefiltert werden.

Und ich gehe davon aus, das es noch viele andere Filterkriterien gibt.

Eine Suchmaschine, die alle Treffer tatsächlich ungefiltert anzeigt, ist mir nicht bekannt.

+ Betr. "Ich lese leider keine Zeitung, so weiß ich nicht, was die Masse der Menschen hier im Land Denkt noch, was ihr hier so vorgesetzt wird zu Glauben.":

Jetzt werd' mal nicht albern. Du liest keine Zeitung; das ist vielleicht das Problem. Man sollte immer mehrere Zeitungen lesen, so wird ein Schuh draus. Aber gut. Und wie sieht 's mit sozialen Kontakten aus? Keine Gespräche mit Frau, Kindern, Enkeln und Nachbarn? Nicht gut, das schadet dem Urteilsvermögen.

+ Betr. "Dies bedeutet, dass eine KI auf die Produktion aus einem anderen schöpft, was zu einer Echokammer von recycelten Ideen und Vorurteilen beitragen könnte.":

C'est ridicule. Ja glaubst Du etwa, die Autoren mehrerer Hunderttausend Verlagstitel, die jährlich erscheinen, haben sich alles aus der Rippe geschnitten? Hast Du schon mal in die umfänglichen Literaturapparate von Doktorarbeiten geschaut? Das wäre bei Gott eine arme Welt, in der jeder nur sagen und schreiben dürfte, was er sich selbst aus den Fingern gesogen hat. Befasse Dich mal mit dem Konzept des Zettelkastens (https://de.wikipedia.org/wiki/Zettelkasten) und Autoren wie Luhmann, Blumenberg, Kittler, die ganze Bücher aus den im Zettelkasten gesammelten Literaturzitaten und Gesprächsnotizen 'synthetisiert' haben.

+ KI ist gekommen um zu bleiben, da beisst die Maus keinen Faden ab. Schlimm wenn Eltern und Grosseltern ihren Kindern und Enkeln die Technik madig machen, statt sie zu einem souveränen und gedeihlichen Gebrauch anzuleiten.

Genau hier liegt das Problem. Du befindest Dich offenbar schon in einer Blase oder Echokammer. Mehre zeitungen nützen nichts, denn erstens schreiben die zu 90% nur Agenturmeldungen ab (die haben extra Redationssystem, die auf copy-paste zugeschnitten sind) und zweitens gibt es im mainstream keine Meinungsvielfalt mehr. Mag sein, daß KI, vielmehr das, was allgemein so bezeichnet wird, aber mit Intelligenz nichts zu tun hat, bleiben möchte. Ich komme mit meiner natürlichen Intelligenz gut zurecht und brauche diesen Quatsch nicht. Bei mir liefert Google auch keine KI Zusammenfassungen (man kann das abstellen!). Soverän und gedeihlich ist, diese Art von KI zu meiden, wie die Pest und eben nicht Kinder und Enkel damit zu versauen.

Auf "Zeit Online" gibt es öfters Pro und Contra Meinungsartikel zu bestimmten Themen. Und dann gibt es ja noch Zeitungen wie die "Berliner Zeitung" oder Nachdenkseiten, die eigentlich bei Leuten Anklang finden sollten, die von "Systempresse" usw. reden.

"schreiben die zu 90% nur Agenturmeldungen ab" das trifft auf Zeit Online sicherlich nicht zu, da gar nicht so viel Alltagskram bearbeitet wird.

Habt ihr echt die Zeit, jeden Morgen mindestens zwei bis drei unterschiedliche Zeitungen zu lesen, ein Linkes und ein Rechtes Blatt um auf der Höhe der Zeit zu sein, beim letzteren wäre mich echt das Geld und die Zeit zu schade.

Auch Online bin ich von Zeitungen und Nachrichten schon seit vielen Jahren genervt, es gibt eigentlich nur noch Schlagzeilen und jede übertrifft möglichst die nächste, über Hintergründe und was danach passiert, wird kaum noch berichtet.

Was juckt es mich, wenn in China ein Sack Reis umfällt, ist mein Leitspruch oder wenn sich jemand in Berlin am Sack kratzt.

Ich höre Radio übers Internet, mehre Sender, wenn mir einer auf die Nerven geht.

Betr. "Habt ihr echt die Zeit, jeden Morgen mindestens zwei bis drei unterschiedliche Zeitungen zu lesen, ein Linkes und ein Rechtes Blatt um auf der Höhe der Zeit zu sein, beim letzteren wäre mich echt das Geld und die Zeit zu schade.":

Von mir aus mach' was Du willst. Das Ganze als Lebensstil zu zelebrieren, halte ich allerdings für bedenklich. Ist denn die Vorstellung, man könne nur morgens Zeitung lesen und es gäbe nur links und rechts, wobei letzteres keine Daseinsberechtigung habe, nicht etwas piefig und einfältig? Das hört sich jedenfalls resignativ an.

+ Betr. "Du befindest Dich offenbar schon in einer Blase oder Echokammer. Mehre zeitungen nützen nichts, … gibt es im mainstream keine Meinungsvielfalt mehr … KI … Ich komme mit meiner natürlichen Intelligenz gut zurecht und brauche diesen Quatsch nicht.":

Wenn ich in einer Blase lebe, lebst Du in einer Höhle ;-). Pass' auf Dich auf, soziale Isolation kann im Alter zu einem schweren Problem werden. Du sprichst von vermeintlich alternativlosem Mainstream in der Presselandschaft und verkennst die immer noch gegebene Pressevielfalt. Erst kürzlich musste ich feststellen, wieviele noch nie etwas von der wieder belebten Weltbühne (https://www.weltbuehne.com/) gehört haben, die einst unter der Leitung von Tucholsky und später von Ossietzky stand. Man muss einfach von links über die Mitte bis rechts die Augen aufhalten, dann findet man genügend Pluralismus.

+ Betr. "nicht Kinder und Enkel damit zu versauen."

Oh oh, hört sich nach religiösem Eifer an. Nicht unbedingt schlecht, das Problem ist nur: Kinder und Enkel werden von anderen damit versaut werden. Da führ' ich die Kurzen dann doch lieber selber in die Materie ein.

Ich nutze G schon länger nur noch bei Term-Suchen. Ansonsten ausschließlich Perplexity und Chat GPT in den Pro-Versionen. Wenn ich mehr Detail brauche, klicke ich auch auf die referenzierten Links. In den KI-Suchmaschinen ist der zukünftige und eher zeitnahe Werbe-Marktplatz für die unzähligen und mehrstellig monatlich wachsenden Free-User-Zahlen. Alle anderen zahlen halt 20 € / Monat ein. Weiß auch nicht, ob ich damit so glücklich bin, angesichts der drohenden Konsequenzen für viele kleinere Anbieter, die das gern auch mal verschlafen…

Das "Freie Internet" liegt schon lange vor "KI" im Sterben. Das fing an als die kommerziellen Aasgeier das Internet entdeckten und sich die WerbeMAFIA breitmachte… und dann alle was vom Kuchen abhaben wollten.

Heute besteht das Netz hauptsächlich aus Copy &Paste; Clickbait und Fakenews.

Hinzu kommt die Influencer Pest, echte Redaktionen die noch echte Recherche betreiben kannst an einer Hand abzählen. JA es gibt sie noch die Blog/Webseiten Perlen, kaum sichtbar und nur für Eingeweihte.

Typische Standard Seiten:80% Werbung 20% Artikel nach obigen Schema…

Tracking wollen wir gar nicht erst anfangen.

Man stelle sich mal vor der heise Verlag ist für die Pressefreiheit mal bis vors Bundesverfassungsgericht gezogen… heut undenkbar, direkt das Negativbeispiel… über 400 Trackingpartner die dich ausspionieren und Artikel nach obigen Schema, zusätzlich sollst du mit Plusartikel ausgenommen werden, welche nix anders sind als wiederverwertete alte Artikel mit gleich viel Substanz wie ComputerBlöd.

Wenn du heute Infos willst gehst am besten direkt zu dpa / Reuters & Co. den der Rest copy&paste sowieso nur und packt noch ihre Ideology dazu, dann doch gleich von der Quelle!

R.I.P

Richtig. Ohne PiHole, NoScript und Co. ist keine echte Internetnutzung mehr möglich. Viele Seiten sind voll mit Clickbait, Werbetrackern, und anderes Zeugs. Hierzu kommen Influencer, dubiose Angebote ("schnell reich werden mit Bitcoin, …") und andere Onlinebetrüger. Es wird auch immer mehr, daß Webseiten von Content Delivery Network (CDN) abhängig sind und sich das Netz mehr zentralisiert anstatt dezentral zu funktionieren. Auch die Zensur z.B. über DNS wird immer weiter ausgebaut … "Alles nur zum Schutz …". Klar, die unendlich Profitgier macht das Internet kaputt!

Tja, ich weiß nicht wie sich die Abozahlen bei Heise in den letzten 20 Jahren entwickelt haben, aber ich schätze mal sie werden nicht nach oben gegangen sein.

Das ist halt das Problem wenn es zu wenig Abonnenten gibt, entweder fängt man an so wie GMX mit Trackern und Werbung Geld reinzuholen oder sie müssen Redaktionen dicht machen.

irgendwas macht Heise richtig, sind immerhin Trikotsponsor bei Hannover 96 (!)

Immer differenzieren: Der heise-Verlag ist nicht heise.de, sondern da hängen Online-Redaktionen, Zeitschriftenverlage, Buchverlage und Schulungen dran. Und was Ansgar Heise dann mit dem Überschuss macht, sollte man nicht unbedingt mit dem originären Thema vermischen.

Heise (Online-Angebot), Golem und auch der Blog hier haben es in den vergangenen Jahren geschafft, sich so weit zu monetarisieren, dass das Angebot aufrecht erhalten werden konnte. Aber das originäre Thema hat einen Blick auf die Zukunft – und wenn ich mir die Zahlen so anschaue, die über Google Werbenetzwerke in den letzten 7 Jahren hier eingespült werden, ist der Trend eindeutig. Kommt jetzt noch ein Besucherrückgang durch AI hinzu, könnte es für so manche/viele Webseiten eng werden.

Die Diskussion hier "die Webseiten schreiben doch eh nur DPA oder voneinander ab", "oder die Qualität ist eh unterirdisch" etc. mag dem eigenen Ego streicheln, geht aber schlicht am Thema vorbei. Einem Offliner mag es egal sein – aber spätestens wenn sich das Angebot im Web spürbar gelichtet hat, könnte es dem einen oder anderen auffallen, das sich was zu vermutlich Unguten entwickelt hat. Im Sinne der Diskussion "es wird ja alles immer schlechter mit der Qualität im Web": Ich verfolge es ja so seit 1996/1997 aktiv mit eigenen Webseiten. Was mal arg kreativ angefangen hat (meine ersten Webseiten waren so was wie Arbeitsproben für meine Bücher), ist in der Zeit bis heute schrittweise ausgedünnt worden. Übrig blieben im Wesentlichen die Dickschiffe. Für die Nische wird es eng – es bleiben ein paar Enthusiasten, einige Community-Projekte und das war es.

Ist aus meiner Sicht die nüchterne Beschreibung der Realität, wie sie sich entwickelt. Aufhalten werden wir sie nicht können – aber ich würde aus heutiger Sicht keine Projekte wie borncity.com, administrator.de etc. mehr neu aufziehen wollen.

Ja, war nur so ein Teaser mit heise (und Online). Heise+ kommt ja auch nicht von ungefär, ob das zündet, weiß ich nicht, aber die müssen/wollen ja auch Geld verdienen.

Das mit der KI gestützten Suche sehe ich auch äußerst kritisch, auch aus praktischen Gründen: die Anzeige der Ergebnisse dauert länger und man muss erst mal ansatzweise prüfen, was da wieder so präsentiert wird. Daher blockiere ich die KI Suche und gehe direkt auf die Webseiten unter den Treffern.

Blogs, die mich interessieren, besuche ich so oder so, wenn der Beifang zurückgeht, ist das natürlich bedauerlich. Aber gäbe es den Trend nich tauch so? Schließlich gibt es ja auch ein höheres konkurriendes Angebot, oder?

Enthusiasten schreiben so oder so, bisher findet man immer noch ein auskömmliches Angebot bei IT Themen.

Viele Blogs und (a) soziale Medien sind so eine Sache, sehe ich in den meisten Fällen als Zeitverschwendung an, sobald man schon bei der dritten Antwort in sinnlose Diskussionen verwickelt wird und das spart man sich dann besser.

Hier geht es moderat zu, so wie auch in meinen bevorzugten Blogs für Hobbythemen und dann steuert man die Seiten auch immer wieder gern an.

Naja, solange man große Vereine sponsoren kann, scheint es ja nicht so sehr zu pressieren mit dem Cashflow.

Ich fixe mal das für Dich: Nicht das freie Web liegt im Sterben. Das werbefinanzierte, auf Tracking der User basierte Web, das liegt im Sterben. Und das sehr gerne bitte zusammen mit den zahlreichen Verlagen und "Angeboten" im Netz, die sich nicht anpassen können oder wollen. Google sucht derzeit noch seinen Weg bzw. hat andere Geschäftsbereiche, die den wegbrechenden Werbemarkt kompensieren können mit einer riesigen Wette auf KI. Wäre nicht übel, wenn die KI Blase da auch wegplatzen würde.

Dem von jedem frei nutzbaren Teil des Internets geht es sehr gut.

Ja und nein. Wir sind uns einig, daß der überwiegende Teil der Inhalte im Internet Müll ist. Der "frei nutzbare Teil", wie Tomas das nennt, wird allerdings sehr bedrängt, weil die großen Contentanbieter das einstige peer-2-peer Internet gerne als reines producer-consumer Netz sehen wollen. Das sieht man schon daran, daß highspeed Anschlüsse immer noch unsymmetrisch mit NAT und ohne öffentliches IPv6 Prefix vermarktet werden. Daher geht es diesem Teil eben nicht sehr gut. Das Internet war dazu da, Informationen und Wissen zu teilen. Heute dient es dazu minderwertige Inhalte zu verkaufen (z. B. über Werbung).

Wann war das Internet "peer-2-peer"? Hab ich was verpasst?

> Das sieht man schon daran, daß highspeed Anschlüsse immer noch unsymmetrisch mit NAT und ohne öffentliches IPv6 Prefix vermarktet werden.

Nein, dieser Vergleich hinkt: Noch nie konntest Du Dir einen Public Internet-Host mit eigener IP bei einem ISP so günstig und unkompliziert anmieten (aktuell für einen Euro im Monat). Das war vor 20 Jahren selten unter 80,- EUR möglich. In den 90er Jahren ging das nur mit Co-Location der eigenen Hardware bei einem POP.

Mach mit der 1,- EUR Kiste ein Reverse-VPN und schon kannst Du daheim Deine Hosts öffentlich hinter Public IPv4 und IPv6 betreiben. Oder was meinst Du, wie ich meine Nextcloud daheim oder der vielen anderen Nextclouds von kleineren Kunden ins Netz bringe, die alle einfache Telekom-Anschlüsse haben? Das sogar resillient, weil es dem VPN Tunnel piep egal ist, wie man ins Internet kommt. Das sogar frei von irgendwelchen Provider-Filtern oder DNS-Sperren.

> P2P-Internet

Usenet. Das WWW war es nie.

Ansonsten hast du natürlich recht. Es war nie einfacher und günstiger, im Web zu publizieren als heute. Allerdings: Die großen Social-Media-Kanäle (erst MySpace, dann FB/Twitter/X, jetzt Insta) ziehen halt die Aufmerksamkeit der Leute massiv an sich, weil sie eben algorithmengestützt "suchterzeugend" sind und am Ende konkurriert man als "content creator" nicht gegen Technik, sondern in einer Aufmerksamkeitsokönomie.

Hat denn das einsetzten dieser AI.txt auf den Webseiten keinen Einfluss auf das nutzen der Inhalte? und wie will Google denn den Traffic ins Netz leiten wenn man die Inhalt Ersteller erstmal gnadenlos ausgedünnt hat?

Mir denken diese AI Entwickler zu kurz. ich hoffe dass sie bald von ihrer Dummheit eingeholt werden und ihr Job abgeschafft wird. dann hat man viel Zeit über das eigene Schaffen nachzudenken 😞

Die AI.txt ist eh nur etwas freiwilliges – von Perplexity (und wohl anderen) fleißig ignoriert. Ich hatte es hier im Blog nicht thematisiert, aber Perplexity nutzte alle technischen Tricks, um Blockiermaßnahmen zu umgehen. CloudFlare hatte das in diesem Blog-Beitrag beschrieben.

Dieses ignorieren ist dann aber doch ein Cpoyright-Verstoß?

Als Ersteller von Webseiteninhalten ist man doch der Urheber und darf bestimmen, was damit gemacht wird. Wenn man da KI-Verarbeitung untersagt…

Da könnte die Springer-Presse ihr Geld mal sinnvoller einsetzen und da mal klagen, anstatt gegen Werbeblocker vorzugehen.

Aktuell läuft ja ein Copyright-Prozess von Publishern in den USA – ist aber nur für Dickschiffe gangbar. Wenn es sich so entwickelt, wie ich es momentan einschätze, wird die KI-Entwicklung erst einen Teil der Webseiten killen und sich dann über LLM-Poisoning selbst die Grundlage entziehen. Warum steht mir diesbezüglich gerade das Bild von Antibiotika ständig vor Augen?

Ja klar verklag die, die haben eine "Kriegskasse" für Anwälte die wahrscheinlich deinen kompletten Umsatz übersteigt.

Als kleiner Webseitenbetreiber bist du pleite bevor es zu einem Urteil kommt.

Der Trick ist, den Streitwert klein zu halten. Dann ist das nicht soooo teuer, bindet aber trotzdem fast genausoviel Zeit. Und als kleiner Anbieter bringt dich dann letztlich entweder die Zeit um, weil in der Zeit die du in den Streit steckst dein Webangebot zurückstecken muss, oder halt das Geld, was du in der verlorenen Zeit nicht verdienen konntest.

Die einzige Chance die ich für nen Kleinen da sehe, ist, sich mit nem Großen als Finanzier zusammenzutun: Der Große finanziert den Streit des Kleinen um ein Grundsatzurteil, das dann auch auf den Großen anwendbar ist.

Hier würde ich zwischen den Interessen der Global Player und dem Freien Internet differenzieren.

Dass bereits seit vielen Jahren, man kann schon von Jahrzehnten sprechen, nicht technikaffine Internetnutzer nur klicken und wischen und dabei Internetadressen in eine Suchmaske, die zum Beispiel von Google bereitgestellt wird, und nicht in die Adresszeile des Browsers eingeben, dürfte allgemein bekannt sein.

Mit der "Künstlichen Intelligenz" findet nur eine weitere Einschränkung der Suchergebnisse statt, die die Entdeckung von Inhalten im WWW wieder auf die Zeit vor den Suchmaschinen zurücksetzt. Damit entstehen auch wieder Möglichkeiten für die reale Welt, in der man mit direkter zwischenmenschlicher Kommunikation Informationen austauscht und digital zusammenfassen und präsentieren kann.

ich sehe das freie Netz nicht in Gefahr. Wer was schreiben will und seine Ansichten teilt, macht dies aus freien Stücken. Haben sie Tiefgang und erfordern aufwändige Recherche, werden Bezahlmodelle implementiert und/oder man verweilt auch länger auf diesen, liest nicht KI Zusammenfassungen.

Bei technischen Blogs wird sich möglicherweise die Spreu vom Weizen trennen, längere Diskussionen, technische Details etc. werden Besucher halten. Das sind dann aber Blogs/Foren mit entsprechenden Beiträgen, nicht Plattformen zum Verkauf neuer Produkte oder 80% belangloses Geschreibsel.

Es gibt sowieso zu viele Blogs, es werden einige überstehen. Eine Bereinigung ist wünschenswert.

Die KI Treffer bei Google u.a. zu Beginn der Recherche sind durch die Bank in meinen Fällen (u.a. IT, Zeitgeschehen und Politik), nicht zu gebrauchen, daher blockiere ich die Ergebnisse, um mich auf das Wesentliche zu konzentrieren.

So weit so Gut,

Wenn aber MS und Google meinen nur noch KI ergebnisse im Edge anzuzeigen dann ist es so.

Die paar die auf einen anderen "normalen" Browser wechseln ist verschwindend gering.

Für 90% der Internetnutzer besteht dieses nur aus Meta, Tiktok usw.

Schau mal auf Allestörungen.de wenn ein Sozialmedia-Dienst eine Störung hat.

Die Meldungen "Mein WLAN geht nicht" bei den ISP's nehmen im gleichen Maße zu

Das Internet kriselt, weil Inhalte durch die nachlassende Qualität der Suchmaschinen und deren falsche Priorisierung (Mobile First, auch am PC) immer schlechter zugänglich sind. Wer will sich denn noch die Arbeit machen, wenn letztlich doch keiner mehr vorbei kommt?

Der Aufwand der Erstellung von Inhalten steigt. Früher war eine Webseite ein einfach mal eben hochgeladenes HTML. Hochladen und liegen lassen hat genügt. Heute muss man da schon mehr für tun.

Warum?

Funktioniert doch letztlich weiterhin – die Information an sich braucht keine super designte Seite (wobei 'super' Design meist nur eine Auswirkung hat: Die Seite wird übermäßig groß)

Wenn ich den HTML-Code diverser Webseiten anschaue, muss man sich nicht wundern, warum die sich oft so lahm anfühlen: Bestehen zu 75% und mehr aus irgendeinem Scriptgedöhns, das für den User null Informationsgehalt hat.

Wenn man einfach nur Infos online stellen will, ist das weiterhin problemlos mit kleinen Mitteln möglich.

Ich bin da ganz der selben Meinung. HTML und gut ist. Mehr brauchts zum Darstellen von Text auch nicht. Die Schriftgröße kann der Benutzer mit Strg+Mausrad bequem regeln. Leider sieht das Google anders und straft alle nicht explizit Mobilgerechten Webseiten mit einem Abstieg in die tiefen der letzten Ergebnisseiten ab. Wer kein responsives Design hat, ist halt nur noch mit Mühe zu finden. Das ist natürlich nicht das einzige Hindernis für eine gute Platzierung.

Alle am eigenen Webprojekt bestehenden Hindernisse kann man hier selbst ermitteln lassen: https://pagespeed.web.dev/?hl=DE

Aus Besuchersicht hast du recht. Aber warum bauen viele Seitenbetreiber den ganzen Script-Mist ein? Weil es Google verlangt! Google hat nämlich Kriterien veröffentlicht, was man als Seitenbetreiber tun und lassen muss, um in die Suchergebnisse und dort möglichst weit vorn hin zu kommen – inhaltliche Qualität zählt nicht dazu. Dazu gehört vielmehr die Verwendung bestimmter „Webtechnologien", die eigentlich keiner braucht, die aber genutzt werden, um alternative Browser auszusperren und Google Trackingdaten zu verschaffen. Auch das Unding, dass so viele Seite schlecht lesbare Textkontraste verwenden (auch in diesem Blog ist die Schrift nicht schwarz auf weiß), haben wir den Design-Vorgaben Googles zu verdanken. Oder es gibt Wörter, die ein Seitenbetreiber in seinen Texten tunlichst zu vermeiden hat: alles, was nach amerikanischen Vorstellungen irgendwie anstößig sein könnte.

– Was wir im Internet finden und was nicht, bestimmt Google. Online stellen kann man viel. Aber was hilft es, wenn es keiner aufruft?

Mundpropaganda ;-P Gutes spricht sich rum… dazu braucht es kein google.

> Aber warum bauen viele Seitenbetreiber den ganzen Script-Mist ein?

Falsch. Monetarisierung funktioniert nahezu nur mit Scripting. Google liest eine reine HTML-Seite mit CSS sogar besser und einfacher ein als eine, die z.B. mit XHR dynamisch zusammen gebastelt wird.

> Google hat nämlich Kriterien veröffentlicht, was man als Seitenbetreiber tun und lassen muss, um in die Suchergebnisse und dort möglichst weit vorn hin zu kommen – inhaltliche Qualität zählt nicht dazu.

Falsch. Ich kenne die Google Search Essentials, früher Webmaster Guidelines) und die sind da sehr eindeutig und widerlegen deine unbelegte Behauptung vollständig.

> Dazu gehört vielmehr die Verwendung bestimmter „Webtechnologien", die eigentlich keiner braucht, die aber genutzt werden, um alternative Browser auszusperren und Google Trackingdaten zu verschaffen

Falls du AMP im Kopf hast: Das war nie verpflichtend, um in Google indexiert oder gerankt zu werden. AMP hat zwar zeitweise Vorteile bei speziellen Features gebracht (z. B. Platzierung in den Top Stories), aber es war immer optional. Heute spielt AMP praktisch keine Rolle mehr, weil Google mobile-optimierte Seiten allgemein bewertet (Mobile-First Index, Core Web Vitals).

Ansonsten bitte elaborieren, welche Webtechnologien das sein sollen.

> Auch das Unding, dass so viele Seite schlecht lesbare Textkontraste verwenden (auch in diesem Blog ist die Schrift nicht schwarz auf weiß), haben wir den Design-Vorgaben Googles zu verdanken.

Auch das mit den Textkontrasten ist nicht Googles „Design-Vorgaben" geschuldet. Das entscheidet der jeweilige Seitenbetreiber selbst. Hier wäre Günther die richtige Adresse, um zu erklären, warum er bestimmte Kontraste gewählt hat. Mein Browser macht das übrigens nicht.

> Oder es gibt Wörter, die ein Seitenbetreiber in seinen Texten tunlichst zu vermeiden hat: alles, was nach amerikanischen Vorstellungen irgendwie anstößig sein könnte.

Falsch. Falls du meinst, dass Google amerikanisches Recht (und, nach dem die Europäer pissig wurden, auch EU/europäisches Recht) beachten muss, stimmt das natürlich. Tendenziell ist EU/europäischeres Recht aber deutlich restriktiver als US-Recht. Allerdings ist das nichts was du Google oder einem andere DSP vorwerfen kannst, sondern darfst dich dazu gerne an deinen Abgeordneten der Legislative wenden.

> Was wir im Internet finden und was nicht, bestimmt Google.

Internet =/= WWW, bitte.

Im WWW hast du zumindest teilweise recht. Das liegt allerdings auch daran, dass sich die Art, wie die Mehrheit das WWW nutzt, von einer eher "fließenden" (aka browsing) Vorgehensweise zu einer eher transaktionalen gewandelt hat. Ich bin seit Mitte der 90er dabei und zu Beginn war es schlicht so, dass man von einer Seite zur nächsten gewandert ist und dabei neue entdeckt hat; Bookmarks waren richtig was und wer die guten Bookmarks hatte (aka die "coolen Kids" kannte), war im Vorteil. Heute sucht man nach etwas, schaut n Seiten an, schließt es ab und beginnt den Zyklus von neuem. Und ja, da hat sich Google gut als DSP positioniert – aber Google hat diesen Trend nicht gemacht. Dieses "Browsing" findet nun eher in Social Media statt, im Prinzip sind das ja automatisch kuratierte Listen an (Micro-)Websites, Bookmarks wurden durch Abos ersetzt und Webringe/Blogrolls durch Followerlisten.

Dass Google im Web so dominant ist, liegt weniger an Zwang als daran, dass Nutzer ihre Suche fast ausschließlich über Google abwickeln. Und ob Google so dominant *bleibt*, tja, das fragt sich auch Google. Googles Business Modell ist ja nicht Seiten zu indexieren und dir ein gutes Suchergebnis zu liefern, sondern Werbung zu verkaufen. Aber wenn die keiner mehr aufruft, weil die Suche nur über LLM läuft?

Kann von mir aus den Bach runter gehen, weil Suchergebnisse waren seit Jahren die erste halbe Seite nur SEO-Spam.

Und diese SEO-Heinis belästigen dann noch Blogbetreiber:

1) Bezahl uns für besseren page rank ;)

2) Wir bezahlen dich für unseren Artikel, veröffentliche das!!

Jetzt ist das SEO-Geschäft *augeblasen* und alle zittern.

Das Lesen von Rezepten oder Anleitungen im Internet ist absichtlich so schwierig und überwältigend wie möglich gestaltet. Diese Artikel sind zu 99 % belanglos, weil sie bei Google mit eine ätzenden emotionalen Story vor dem echten Inhalt besser ranken. Jedes Rezept oder jedes How-to, den ich lese, würde gerade so auf die Größe eines Handydisplays passen. Stattdessen muss ich warten, bis die ganze Seite geladen ist, etwa 70 % nach unten scrollen, dann warten, bis der Newsletter erscheint und alle Anzeigen geladen sind, wodurch die Seite sich bewegt.

Google ist maßgeblich für dieses Verhalten verantwortlich, da Google bei der Suche Länge am höchsten bewertet und Kürze oder Nutzererfahrung scheinbar nicht.

Howtos usw. sind eh die "Besten"… Wenn man mal eine Anleitung für irgendwas sucht, z.B. wie bekomme ich Notebook xyz oder so auf, um die SSD auszutausschen. Statt nem kurzen Text mit ein paar Bildern wo die Schrauben versteckt sind und wo man was wie aufclipsen muss landet man sehr oft bei so Selbstdarstellern auf Youtube, 30 Minuten Blablabla mit Zig Werbeeinblendungen die man erst nach 1-2 Minuten überspringen kann bis es dann endlich zur Sache geht. Zeit, Strom, Bandbreite und Speicherplatz ohne Ende verschwendet.

Ich höre meistens an der Stimme ob das ein Fake-Repair-Video ist:

>TTS roboter redet

>nur texteinblendungen

>ki-stimme

Denke jeder hier hat genug Menschenkenntnis nach 10 Sekunden einfach die Fakedinger zuzuklicken.

Ich habe alle AI/KI-Robots etc. per .htaccess bei meiner Homepage gesperrt.

Denn die verursachen extremen Traffic.

Bei meiner Homepage wurde vor der Sperrung von AI/KI über 90% des Traffics von deren Robots verursacht.

Und wenn sich die Robots als was ganz anderes ausgeben?

Denen kommt man nach und nach auf die Spur und sperrt dann die IP-Adressbereiche, über die die zugreifen.

Denn diese IP-Adressbereiche werden i.d.R. nicht von normalen Benutzern verwendet.

Perplexity macht sich z.B. dadurch bemerkbar, das die Browserkennungen meist total veraltet sind.

Beispielsweise Chrome 100 oder Chrome 110.

Aktuell ist Chrome 140.

Wertest du deine Webserverlogs danach aus? Das ist sicher ein Haufen Arbeit…

Ja, die Webserverlogs werte ich aus.

Das würde mich nicht wunder, bei diesen "Raubmordkopierern".

Gab es da nicht schon Fälle?

dann blockst Du ganze ASNs

hier ein Bash-Skript, das ich mal vor Jahren angefangen habe gegen aggressive ahref-Bots und Pentesttools gebaut habe, die alle möglichen Verzeichnisse eines Servers durchprobieren. Den ASN Block habe ich heute extra für Dich hinzugefügt ;-)

https://codeberg.org/tomas-jakobs/http-limiter

Eine schlimme Sache dabei dabei ist auch ein monetärer Aspekt, der oben noch garnicht thematisiert wurde. Du als Seitenbetreiber bezahlst den Traffic der KI-Bots auf deiner Webseite. Du bezahlst dafür, dass sie dir dann durch die KI-Zusammenfassung bei der Suche noch die Besucher weg nehmen.

Wieviel Seiten pro Sekunde-Anfragen kann man denn von einer "normalen" IP-Adresse mit Mensch(en) dahinter erwarten? Ich vermute, dass Crawler saugen, was geht – könnte man da nicht ansetzen? Extragroße (Peronal)-Firmen-IPs könnte man bei sowas vielleicht ausschließen?

Die Frage lässt sich nicht pauschal beantworten und kommt darauf an auf a) die Website (wieviele http Request sind pro Seitenaufruf für Bilder, CSS, JS, 3rd party Content notwendig) und b) auf die Audience, der Anwender, die damit arbeiten. Hast Du eine B2B Plattform stecken hinter einem Proxy oder Unternehmens-IP halt mehrere hundert oder gar tausende Anwender mit Ihren Requests.

Meine persönlichen Erfahrungswerte im ganz normalen Mittelstand:

– Ban bei 100 neue Verbindungen binnen 10 Sekunden pro IP

– Ban bei 250 aktiven Verbindungen per /24 IPv4 Netz

– Ban bei 250 aktiven Verbindungen per /64 IPv6 Netz

und wie oben bereits genannt jetzt neu der optionale Ban aller IP Blöcke hinter einer ASN. Wenn Du also komplett Meta mit all seinen weltweiten IPs blocken willst, brauchst Du nur deren ASN anzugeben.

Eine .htaccess ist der denkbar schlechteste Ort. Sowas machen Firewalls oder Router oder vorgelagerte WAF/Proxies schneller und besser als ein Webserver.

Ich habe weiter tiefer im Thread Link auf ein "DDOS für Arme" Bash-Skript hinzugefügt, lauffähig auf jedem GNU/Linux Debian.

Hilft mir nichts, denn die Webseite liegt bei einem externen Hoster und da habe ich keinen Zugriff auf Firewall, Proxies, Router, etc. etc.

Ich kann da nur per .htaccess, robots.txt etc. den Zugriff steuern.

Die robots.txt wird z.B. von perplexity ignoriert, also muß ich die per .htaccess aussperren.

Du kannst es mit Botbomben versuchen.

dd if=/dev/zero bs=1M count=10000 | gzip > 10G.gzip

Und das File verlinkst du auf deiner Seite an einer unsichtbaren Stelle, z.b. auf einem transparenten Pixel. Die Zip-Datei ist recht winzig, und wenn die Bots die runterladen und zur Analyse auspacken, bekommen sie dicke Backen.

Dann hat der externe Hostinganbieter hoffentlich keinen Viren/Trojanerscanner auf dem Server laufen, der die auch auspackt…

Betr. "Du kannst es mit Botbomben versuchen.":

Wenigstens hast Du noch "versuchen" dazugeschrieben. Ansonsten: Ich bitte Dich, solche Mätzchen konnte Windows AV Software schon Mitte der 2000er erkennen. Du glaubst doch nicht, dass ein aktueller Crawler auf so was hereinfällt.

Ganz schlechte Empfehlung, wenn Du nicht willst, dass Schlangenöl die Domain bzw. IP als Malware Website auf irgendwelche Blocklists setzt, die Du dann versuchen kannst loszuwerden. Wenn Dich zuvor der ISP nicht schon gekündigt hat.

https://www.spiegel.de/wirtschaft/google-gemini-ai-overviews-ki-bots-macht-kuenstliche-intelligenz-den-journalismus-kaputt-a-9f43cc73-a660-4978-9d3f-c567c0ddd293

Auch andere Medien greifen das Thema jetzt auf, der Spiegel am Beispiel der Apotheken-Umschau, allerdings ist der Artikel hinter Paywall.

Ausgerechnet der Spiegel beklagt einen kaputtgehenden Journalismus, dort ist man eigentlich seit Jahren auf diesem Weg…

Nunja, reflexhafte Antworten liegen meistens daneben. Der Spiegel Artikel beleuchtet an der Apotheken Umschau, wie AI-Anbieter journalistische Angebote kaputt machen. Der Beitrag beschreibt recht gut das Kernproblem, und passt 100% zu den Aussagen in obigem Artikel.